GPT-4o يتصدر الساحة | نموذج جديد خارق ومجاني من OpenAI!

أقامت شركة OpenAI الرائدة في مجال الذكاء الاصطناعي حدثًا مباشرًا على الإنترنت لاستعراض أبرز تحديثاتها الجديدة إلى نظام الذكاء الاصطناعي الأشهر ChatGPT؛ وهو حدث تحديثات الربيع Spring Updates المُقام في يوم 13 مايو 2024. وأعلنت الشركة عن نموذج جديد رائد للذكاء الاصطناعي، نموذج GPT-4o، والذي يُعد أقوى التحديثات التي حصل عليها نموذج GPT على الإطلاق!

يُقدم هذا النموذج مزايا متطورة وغير مسبوقة في مجال الذكاء الاصطناعي مُتعدد الوسائد؛ إذ استعرضت OpenAI بيانًا عمليًا للقدرات الخارقة التي يُقدمها هذا النموذج، إذ يُصبح ChatGPT بهذا التحديث قادرًا على رؤية وفهم الصور والفيديو، وسماع وفهم الأصوات، وقراءة النصوص، بالإضافة إلى ربط بين هذه الوسائط المختلفة في سياق واحد.

بهذا التحديث؛ نظام ChatGPT يرى، ويسمع، ويتكلم!

أعلنت OpenAI عن تحديثات جذرية في سياستها تجاه النسخة المجانية من ChatGPT؛ إذ يحصل مستخدمو النسخة المجانية أخيرًا على المزايا الخارقة لنموذج GPT-4؛ فقد قررت عملاقة الذكاء الاصطناعي إطلاق GPT-4o إلى النسخة المجانية والنسخة المدفوعة على حدٍ سواء. وتُعد هذه الخطوة من OpenAI دليلًا على التزام الشركة بمبادئها التأسيسية، والتي لم تهدف أبدًا إلى الربحية؛ وذلك وسط الصراعات القضائية مع إيلون ماسك، الملياردير الأمريكي والشريك المؤسس؛ إذ يحاول ماسك ملاحقة الشركة قضائيًا بدعوى خرق اتفاق التأسيس والتحول إلى الربحية.

تسعى OpenAI بهذا التحديث إلى تحقيق الريادة في مجال الذكاء الاصطناعي مُتعدد الوسائط؛ ذلك لتتمكن من مُقارعة منافسها الأقوى من جوجل Gemini. ورغم أن جيميناي نموذج مُصمم من البداية ليكون تعدد الوسائط؛ ما زالت هذه القدرات قيد التطوير في جيميناي. ولهذا قد يُصبح ChatGPT-4o النموذج الأول الذي يُقدم خدمات الذكاء الاصطناعي مُتعدد الوسائط بشكل كامل!

طالع أيضًا: Gemini Advanced | كيف يبدو جيميناي برو أمام جيميناي ألترا؟

نستعرض في هذ المقال أبرز إعلانات OpenAI خلال حدثها المباشر الأخير، مع نظرة عامة على الخدمات الجديدة التي سيحصل عليها ستخدمو النسخة المجانية مقارنةً بالنسخة المدفوعة.

نموذج GPT-4o – أول نموذج يُقدم قدرات تعدد الوسائط!

لن تجد OpenAI موضوعًا أهم من نموذج GPT-4o لتفتتح به حدثها المُنتظر؛ فقد استعرضت الشركة في بداية المؤتمر القدرات الخارقة التي يُمكن لهذا النموذج الجديد تقديمها؛ خاصةً في مجال المحادثات الصوتية، بل ومحادثات الفيديو! فكما ذكرنا؛ يُصبح ChatGPT بهذا التحديث قادرًا على الرؤية والاستماع والكلام.

تحدثت OpenAI عن قدرات تعدد الوسائط التي تظهر في أبهى صورها خلال إدارة GPT-4o للمحادثات الصوتية. سابقًا؛ كان من الممكن التحدث مع ChatGPT بالفعل؛ ولكن ممن خلال ثلاث عمليات مختلفة. تعتمد العملية الأولى على تحويل صوت المستخدم إلى نص؛ ثم تبدأ العملية الثانية الخاصة بمعالجة هذا النص كأي أمر نصي آخر بواسطة قدرات الذكاء والمنطق بالنموذج؛ لتبدأ العملية الثالثة والأخيرة بتحويل نتيجة هذه المعالجة النصية إلى صوت يخرج للمستخدم في النهاية. ولهذا كانت المحادثات الصوتية تُعاني من تأخر في الاستجابة لمدة 2 إلى 5 ثوانٍ في نماذج GPT السابقة.

والآن مع نموذج GPT-4o الجديد؛ سيكون النموذج قادرًا على فهم المحادثات الصوتية بشكل مُباشر؛ إذ درَّبت الشركة هذا النموذج من البداية ليكون قادرًا على التعامل مع الوسائط المختلفة (صور، فيديو، صوتيات، نصوص)؛ فهو قادر على فهم هذه الوسائط بالشبكة العصبية ذاتها!

ولهذا؛ تفوقت OpenAI على جوجل في إطلاق أول نموذج قادر على تقديم قدرات تعدد الوسائط بشكل كامل!

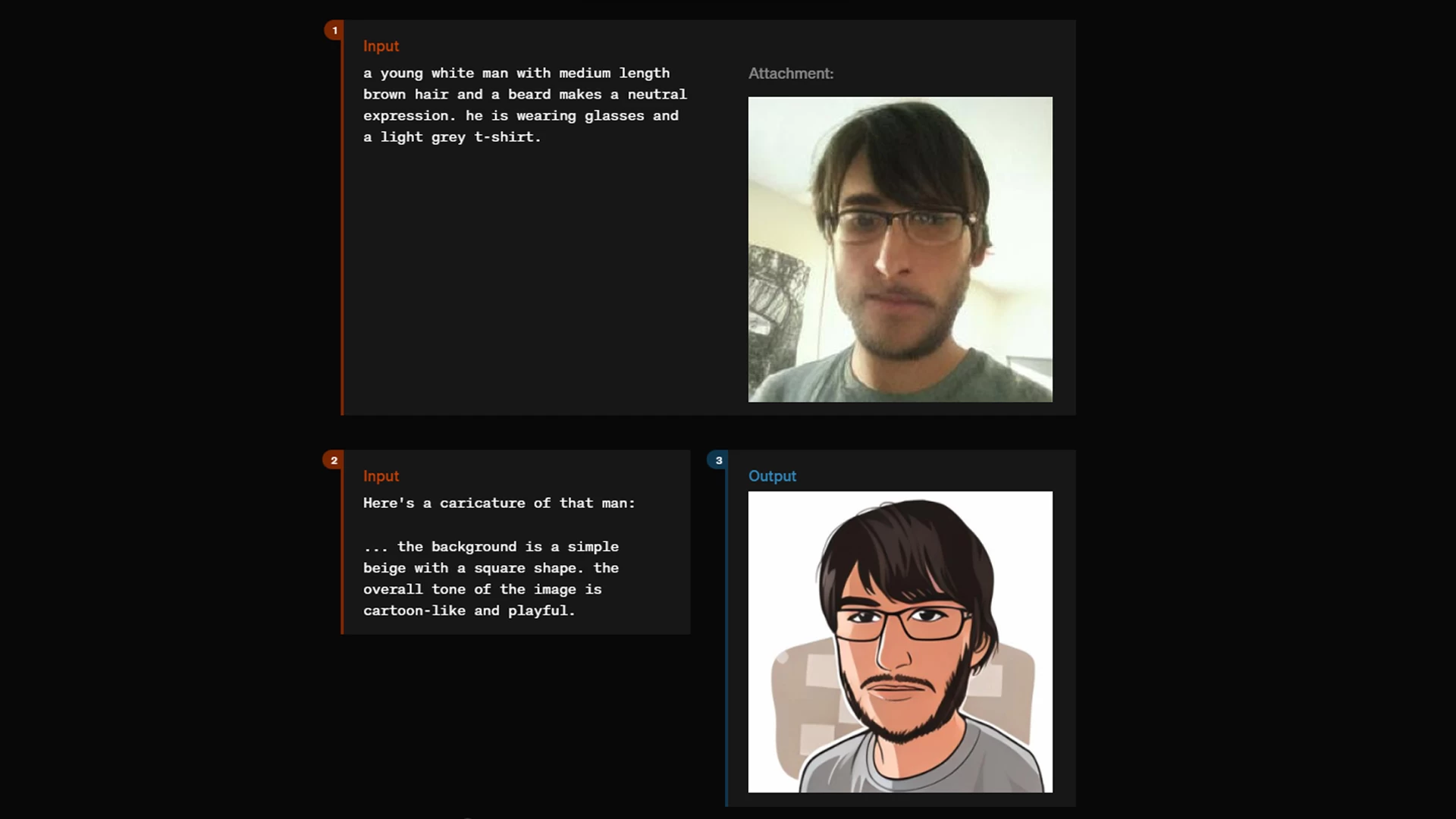

وفي بيان لقدرات GPT-4o على رؤية وفهم محتويات الصور، والربط بينها وبين النصوص في نفس السياق؛ أظهرت OpenAI اختبارًا بسيطًا لـ ChatGPT-4o يطلب من النموذج توليد رسم كاريكاتير من صورة مُرفقة مع أمر نصي يصف محتوى الرسم المطلوب. ونجح النموذج بالفعل في فهم قصد المستخدم بإنتاج كاريكاتير مستوحى من الصورة المُرفقة بشكل مُطابق لوصف المستخدم!

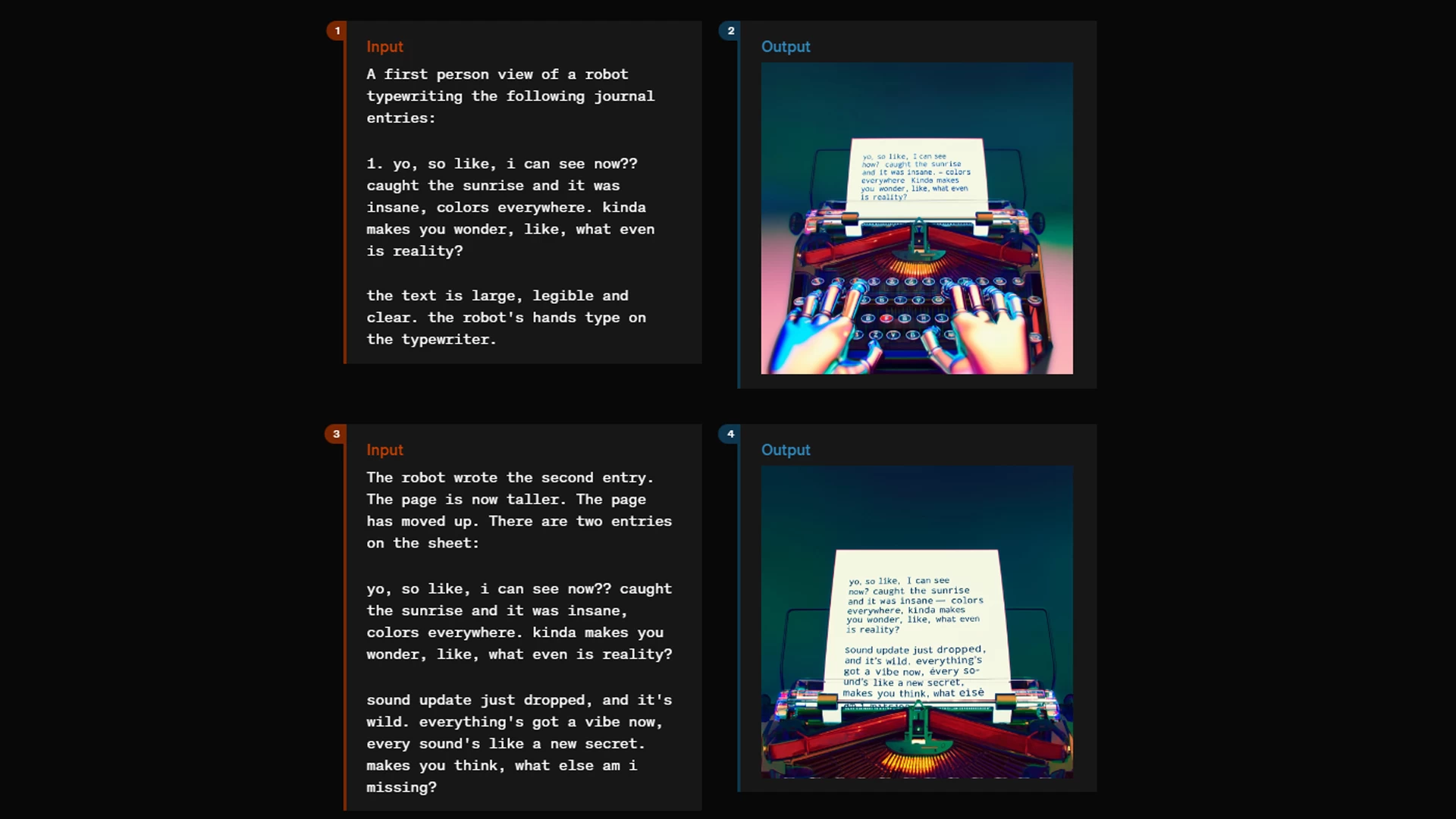

استعرضت OpenAI عددًا من قدرات النموذج الأخرى في فهم وإنتاج العديد من الصور؛ خاصةً التي تحتوي على نصوص بداخلها. فقد عانت نماذج تحويل النصوص إلى صور من إضافة النصوص داخل الصور المُولَّدة؛ ذلك بسبب انفصال نماذج توليد الصور عن نماذج توليد النصوص. ولكن كما ذكرنا؛ يعمل GPT-4o على شبكة عصبية مُوحدة ومُدرَّبة على التعامل مع كافة الوسائط المختلفة من نصوص وصور وصوتيات وغيرها.

استعرضت OpenAI أيضًا قدرات نموذج GPT-4o على فهم وقراءة التعبيرات والمشاعر البشرية؛ بل ومحاكاتها أيضًا في نبرة الصوت التي يتحدث بها النموذج! فبهذه القدرات؛ يُصبح النموذج قادرًا على إجراء محادثات فيديو مع المستخدمين، إذ سيكون النموذج قادرًا على قراءة وتحليل تعبيرات وجه المستخدم خلال المحادثة، كما سيتمكن من فهم مشاعره عبر تحليل نبرة صوته مع التفاعل معها صوتيًا خلال المحادثة.

باختصار؛ ستشعر أنك تتحدث إلى صديقك!

ستُحدث هذه القدرات طفرةً غير مسبوقةٍ في مجال الترجمة الحية والمباشرة؛ إذ أكدت OpenAI على التزامها بدعم النموذج لأكبر عدد ممكن من اللغات، واللهجات الخاصة بها أيضًا؛ فقد تخطى عدد اللغات التي يدعمها ChatGPT حاليًا 50 لغةً. وتأتي العربية على رأس هذه اللغات بالطبع.

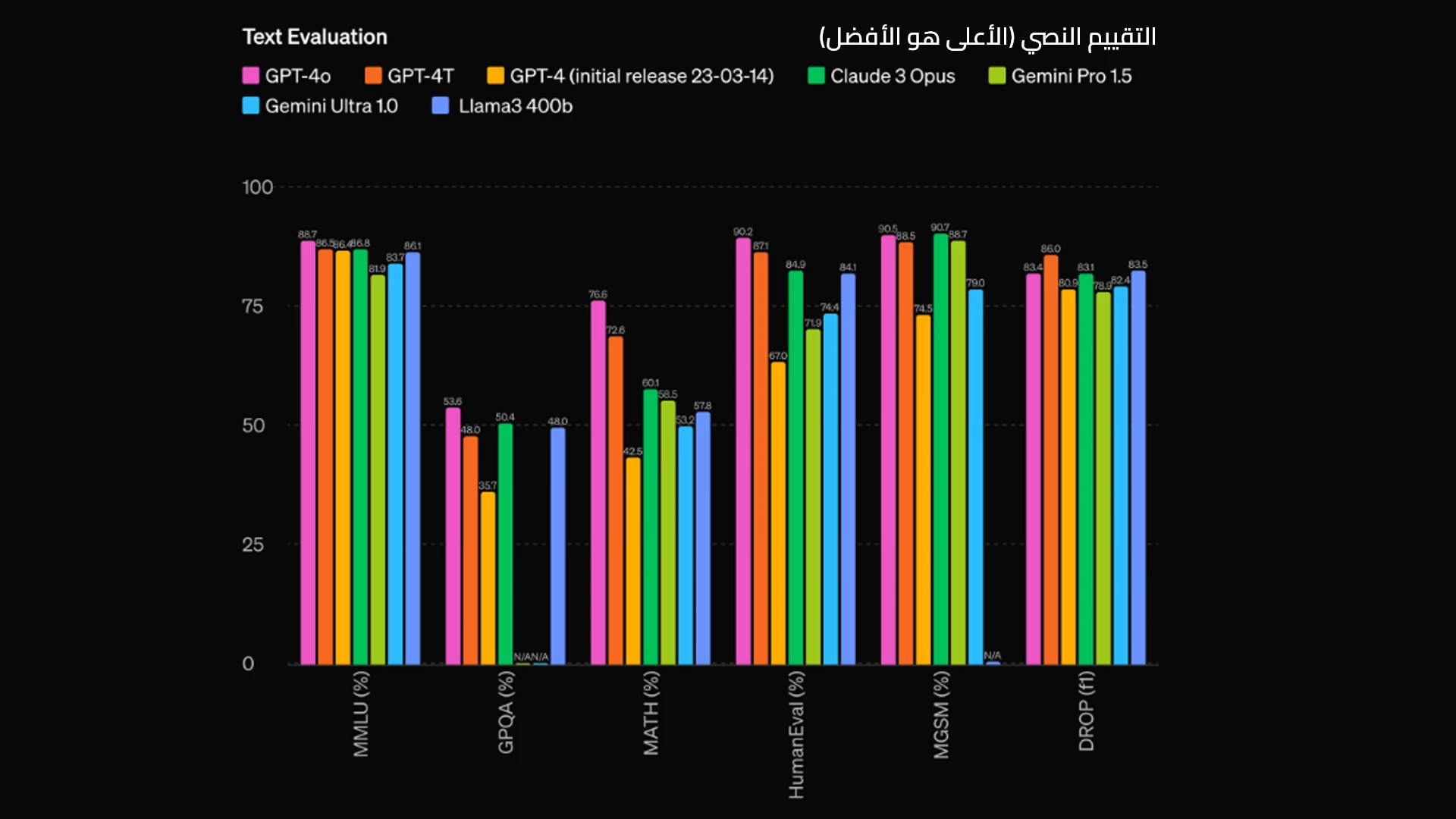

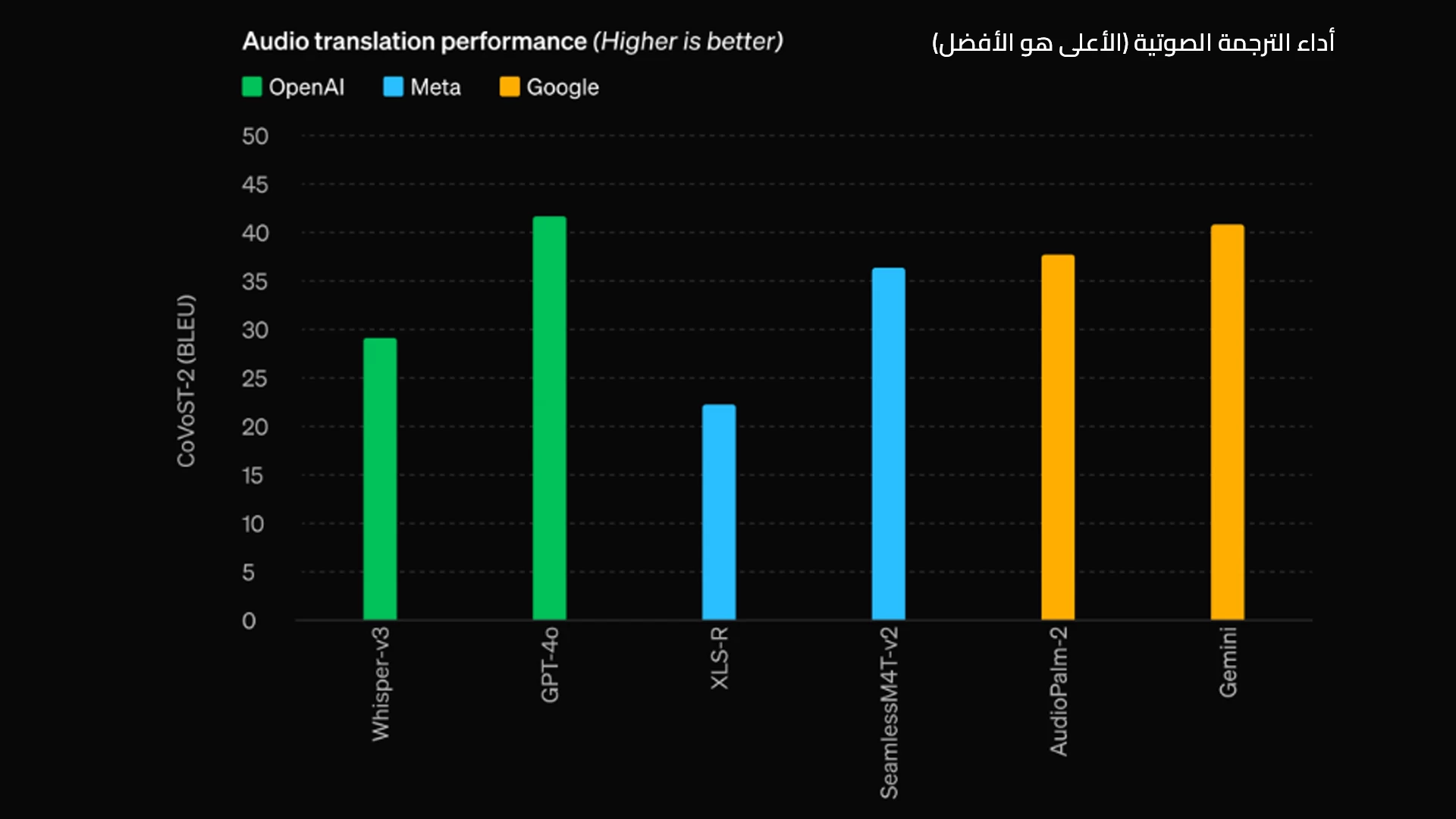

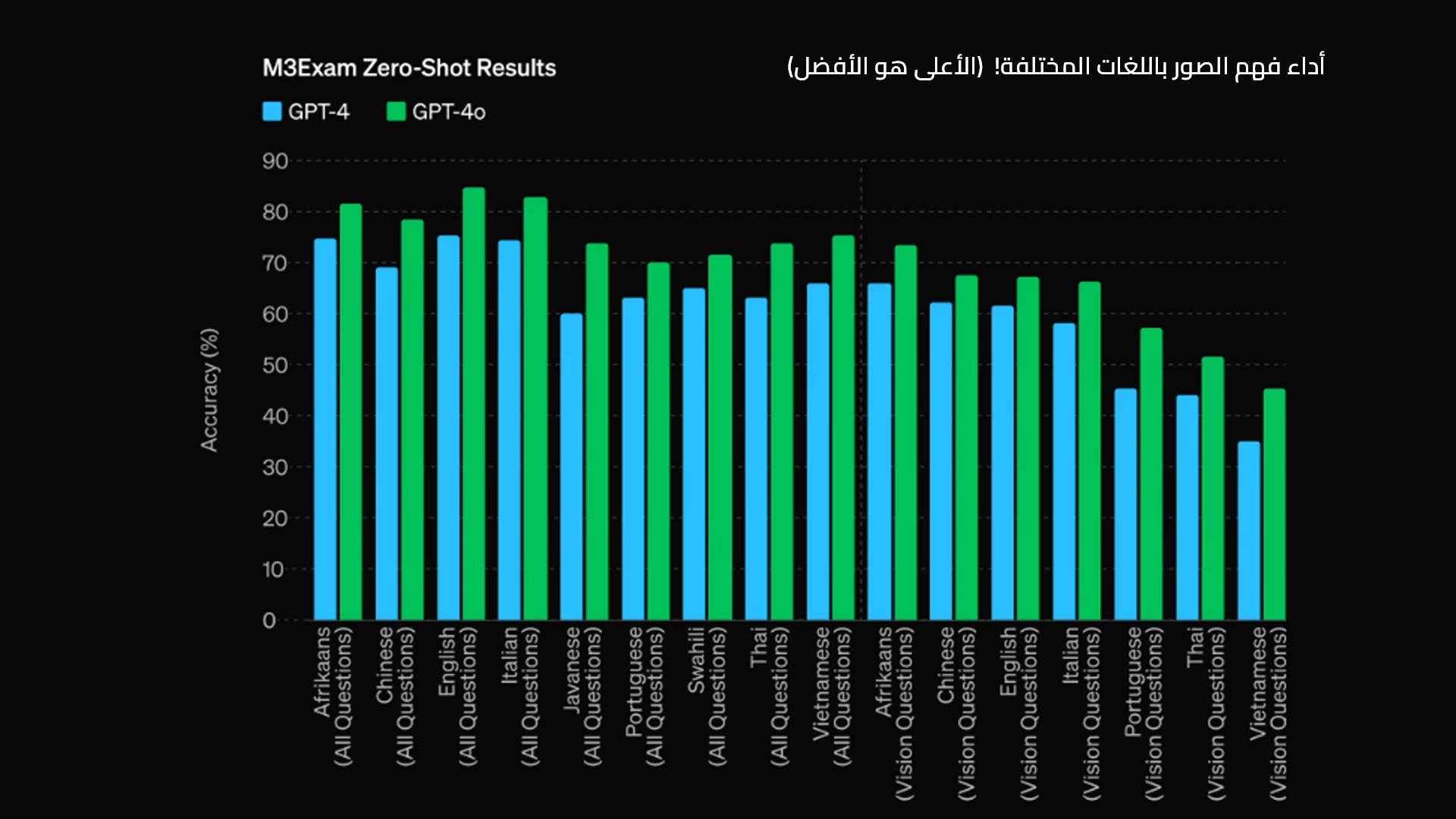

وبالنسبة لاختبارات الأداء؛ نستعرض لكم عددًا من أشهر اختبارات الأداء المُوجهة إلى تقييم أداء قدرات تعدد الوسائط بنماذج الذكاء الاصطناعي؛ والتي استعرضتها OpenAI خلال حدثها المباشر:

بهذه النتائج؛ يُمكن اعتبار GPT-4o نموذج الاصطناعي الأقوى على مستوى العالم!

تطبيق ChatGPT يصل إلى أجهزة الكمبيوتر!

أعلنت OpenAI خلال فعاليات هذا الحدث المباشر عن إطلاق تطبيق جديد مُوجه إلى أجهزة الكمبيوتر؛ إذ كشفت الشركة أنها ستبدأ بإطلاق النسخة المُوجهة لأجهزة الـ MacOS بدءًا من اليوم؛ وكشفت الشركة أنها تسعى إلى إطلاق هذا التطبيق إلى أنظمة الشغيل الأخرى كالويندوز خلال الأسابيع القادمة، ولكنها ستبدأ حاليًا بإطلاقه على أجهزة الماك فقط. وأكدت الشركة أن التطبيق سيعمل على النسخة المجانية والنسخة المدفوعة على حد سواء!

يعمل هذا التطبيق كمساعد شخصي بالأوامر الصوتية من خلال الاختصارات السريعة على لوحة المفاتيح. وسيقدم التطبيق قدرات غير مسبوقة وفريدةً من نوعها عند إطلاق نموذج GPT-4o إلى ChatGPT؛ إذ ستتمكن من إجراء مُحادثات صوتية مباشرة مع مساعدك الشخصي (ChatGPT) على الكمبيوتر للتفكير أو النقاش في حل المشكلات المختلفة التي تواجهها خلال عملك على الحاسوب!

التوفر..موعد إطلاق GPT-4o

لم تُحدد OpenAI موعدًا رسميًا لإطلاق نموذج GPT-4o؛ ولكن كشفت الشركة أنها ستبدأ في إطلاقه في أقرب ممكن خلال الأسابيع القادمة. وكشفت OpenAI أن GPT-4o سيُقدم أداءً يصل إلى ضعف سرعة GPT-4 Turbo بنصف سعره فقط!

مع إطلاق هذا النموذج؛ سيحصل مستخدمو النسخة المجانية على الخدمات الآتية للمرة الأولى بشكل فوري:

- الوصول إلى أقوى قدرات الذكاء في ChatGPT من خلال نموذج GPT-4o

- الوصول إلى متجر بوتات الدردشة المُخصصة (القائمة على نموذج GPT) من خلال متجر GPT Store

- استخدام قدرات تعدد الوسائط في فهم وتحليل الصور

- إمكانية استخدام النموذج في تلخيص المستندات النصية وتحليل البيانات الضخمة وإنشاء الرسوم البيانية

- تجربة خاصية الذاكرة الجديدة الموجودة في GPT-4 حاليًا؛ والتي تجعل ChatGPT قادرًا على تمييز خصائص المستخدمين لتقديم تجربة استخدام مميزة، ومُخصصة لكل مستخدم

ومع ذلك؛ لن يتمكن مستخدمو النسخة المجانية من تجربة المزايا الصوتية الجديدة في GPT-4o عند إطلاقه؛ إذ قررت OpenAI إطلاق هذه المزايا إلى المشتركين في الخطط المدفوعة أولًا. ولكن أكدت OpenAI أنها ستُتيح لاحقًا جميع مزايا GPT-4o لمستخدمي النسخة المجانية، بما يتضمن القدرات الصوتية والمساعد الشخصي الصوتي!

هل نموذج GPT-4o مجاني بالكامل؟

نعم؛ تنوي شركة OpenAI جعل نموذج GPT-4o مجاني بالكامل، ولكن ستبدأ أولًا في إطلاق المزايا الصوتية للنسخة المدفوعة قبل أن تصل للنسخة المجانية. وبالطبع ستحصل النسخة المجانية على عدد أقل من الأسئلة يوميًا مقارنةً بالخطط المدفوعة

متى يُصبح GPT-4 متاحًا للنسخة المجانية؟

ستحصل النسخة المجانية على قدرات GPT-4 عندما تُطلق الشركة نموذج GPT-4o خلال الأسابيع القادمة، إذ سيعمل النموذج الجديد على النسختين المجانية؛ والمدفوعة

هل يحصل الويندوز على تطبيق ChatGPT؟

نعم، سيحصل الويندوز على تطبيق ChatGPT خلال الأسابيع القادمة، ولكن بدأت الشركة في إطلاق التطبيق اليوم إلى الـ MacOS فقط

هل نموذج GPT-4o مُتعدد الوسائط بالكامل؟

نعم؛ سيُقدم نموذج GPT-4o قدرات الذكاء الاصطناعي مُتعدد الوسائط فورًا بعد إطلاقه؛ ليصبح النموذج الأول الذي يُقدم هذه القدرات بشكل كامل