AMD تستعرض أحدث مُسرّعات AMD Radeon Instinct في حدث AMD Advancing AI

خلال فعاليات حدث AMD Advancing AI الذي أقيم اليوم في الولايات المُتّحدة الأمريكية، وتحديدًا مدينة سان فرانسيسكو في ولاية كاليفورنيا، استعرضت شركة AMD العديد من المُنتجات الجديدة التي ركّزت على تسخير قُدرات الذكاء الاصطناعي لراحة المُستخدمين. وكالعادة، سافر فريق عرب هاردوير لتغطية الحدث المُهم، ونقل صورة حيّة ومواكبة للحدث.

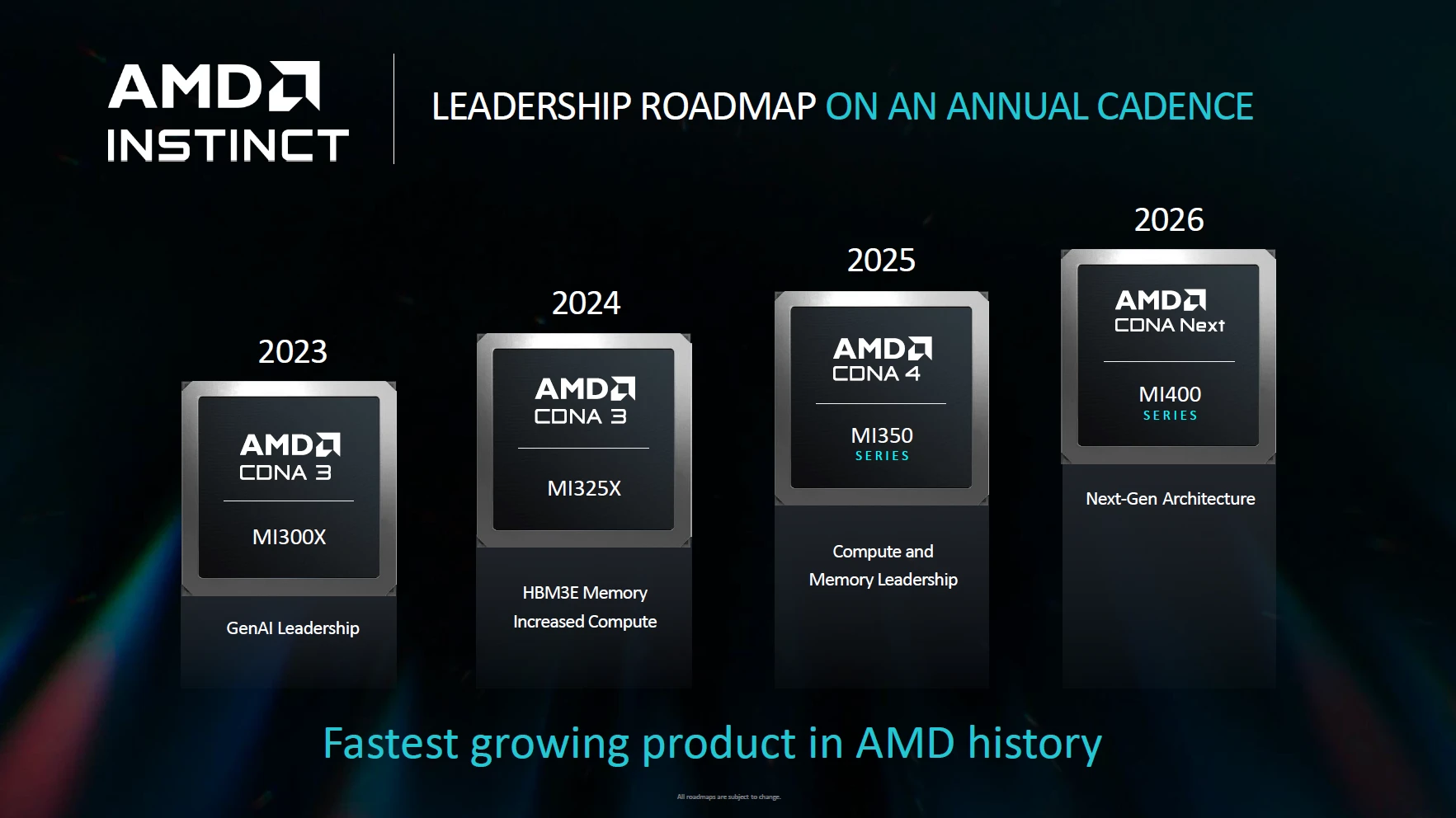

أطلقت AMD مُسرّعات Instinct MI300 للمرة الأولى في ديسمبر 2023، لتُصبح بعد ذلك واحدة من أكثر مٌسرّعات الذكاء الاصطناعي الرائجة في السوق، مع مبيعات 1 مليار دولار في أقل من نصف عام. وفي معرض Computex الماضي، أعلنت الشركة عن مُسرّعات MI325X كواحدة من أكثر الحلول تقدمًا على صعيد الأداء ومكوّنات الذاكرة. واليوم تُقدّم AMD هذه المُسرّعات للعلن.

بالإضافة إلى ذلك، أعلنت AMD عن تطوير بيئة ROCm مفتوحة المصدر لتخدم عملائها بشكل أفضل، مع تقديم حلول الشبكات الذكية AI Networking الأكثر تطوّرًا. ولإيصال مُنتجات الذكاء الاصطناعي لعدد أكبر من المُستخدمين، أعلنت الشركة أيضًا عن جيل جديد من معالجات EPYC 9000، ومعالجات AMD Ryzen AI 300 Pro للخوادم والمُستهلكين؛ وذلك لإيصال حلول الذكاء الاصطناعي لأكبر عدد مُمكن من العُملاء والمُستخدمين حول العالم.

مسرّعات الذكاء الاصطناعي Radeon Instinct

لدينا في البداية كروت الشاشة ومُسرّعات الذكاء الاصطناعي من سلسلة Instinct الجديدة. هذه المرّة تهدف استراتيجيّة AMD إلى الالتزام بمعايير الأداء الأفضل، والموثوقية الأعلى من خلال توفير بيئة مفتوحة المصدر لمُنتجاتها، مما يجعل مُشاركة الأعمال أكثر سهولة. هذا بجانب توفير سهولة أكبر في الانتقال إلى منصّة AMD حتى مع وجود بنية تحتية مُسبقة، دون الحاجة للكثير من التعقيدات؛ مما يوفّر نجاحات أكثر للعُملاء.

الجيل الجديد من Radeon Instinct بالفعل موجود في العديد من مُزوّدي خدمات الذكاء الاصطناعي مثل Microsoft وOpenAI وMeta بالإضافة إلى عدد كبير من مزودي هذه الخدمات. كما أن العديد من شركات تصنيع الحواسيب العالمية، سواء تلك التي تمتلك خوادمها الخاصّة أو تستعين بخوادم خارجية، مثل HP/ASUS/Gigabyte/Oracle وغيرها، تستخدم هي الأُخرى هذه المُنتجات الرائدة من AMD.

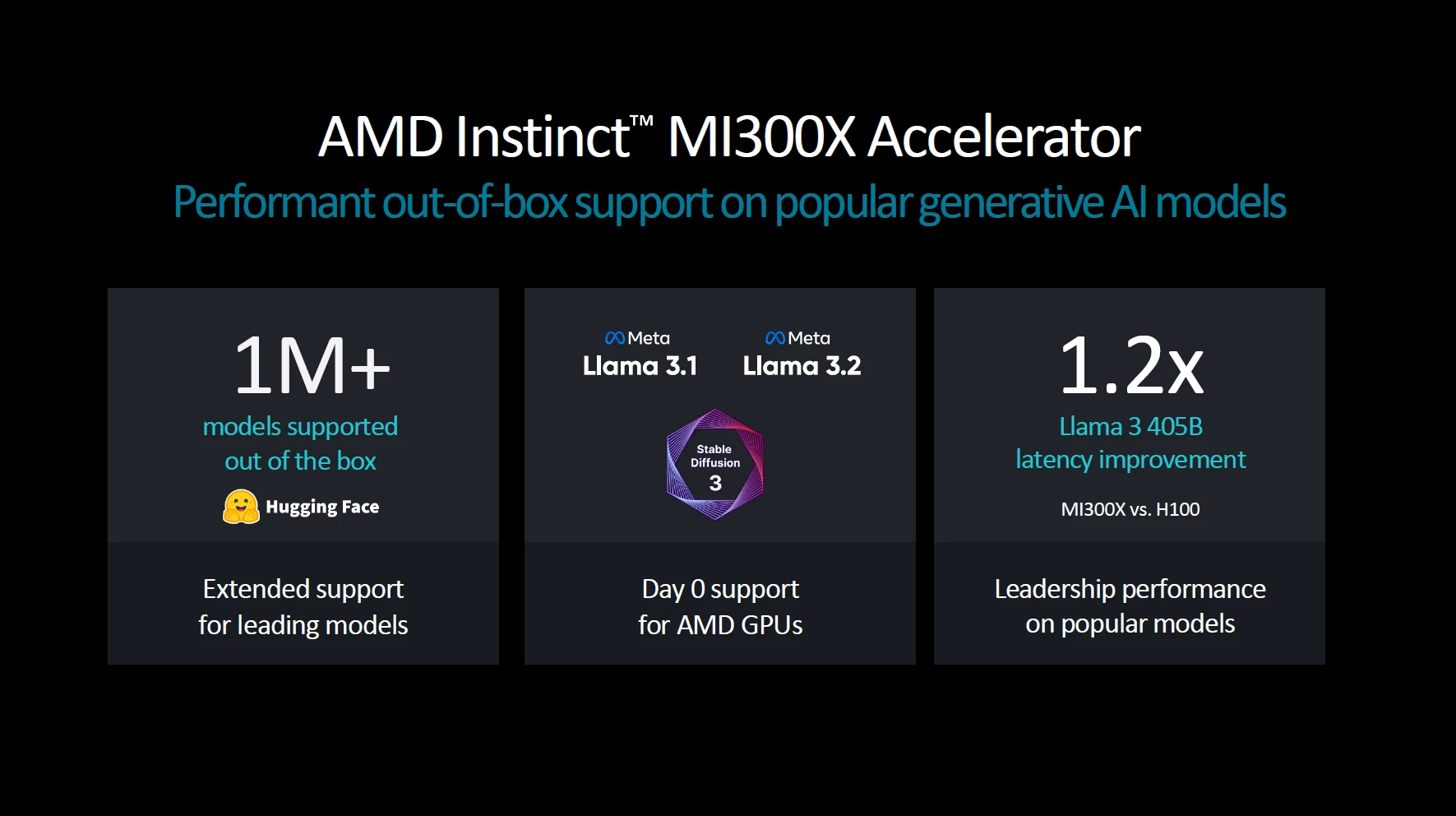

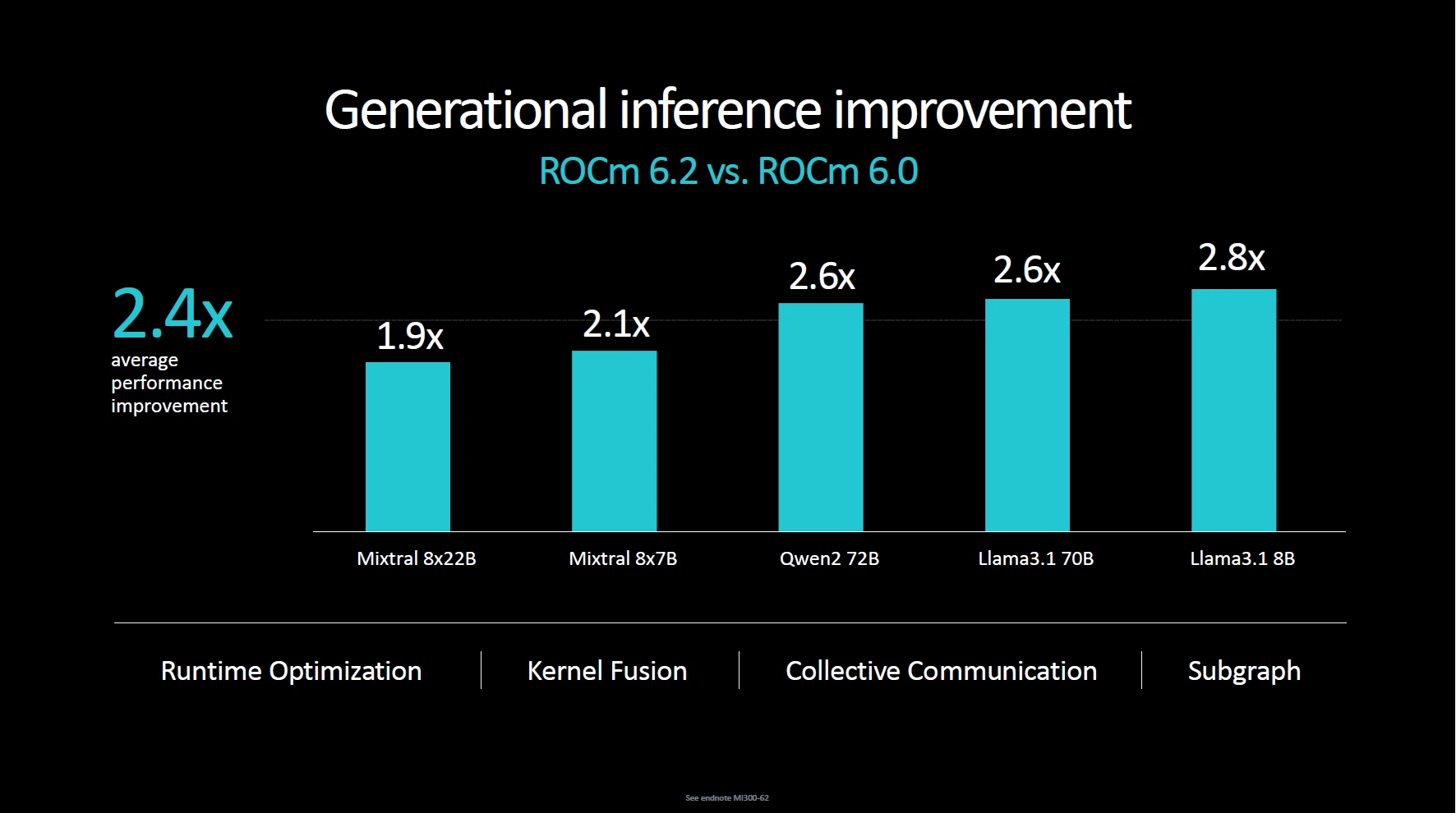

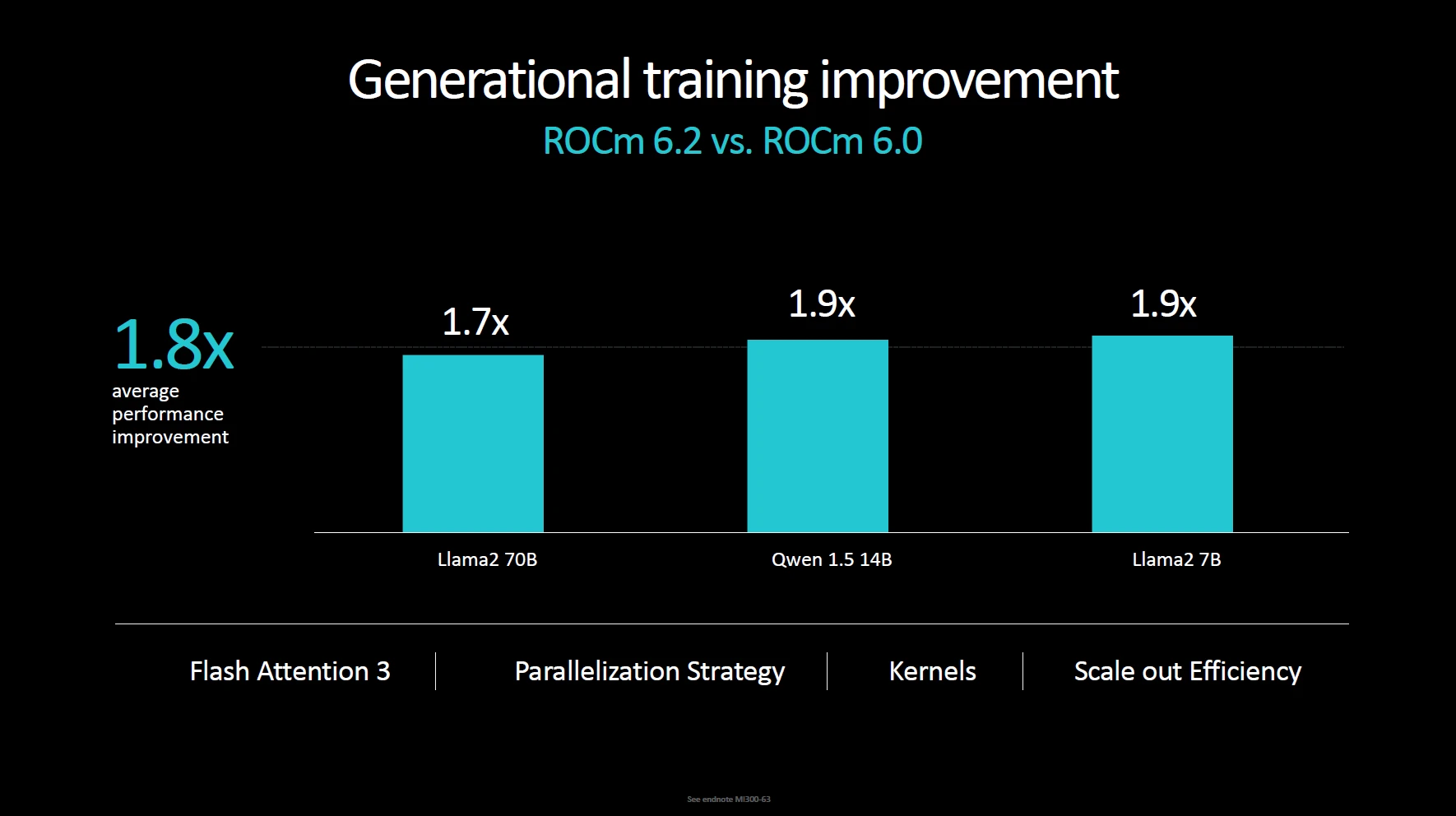

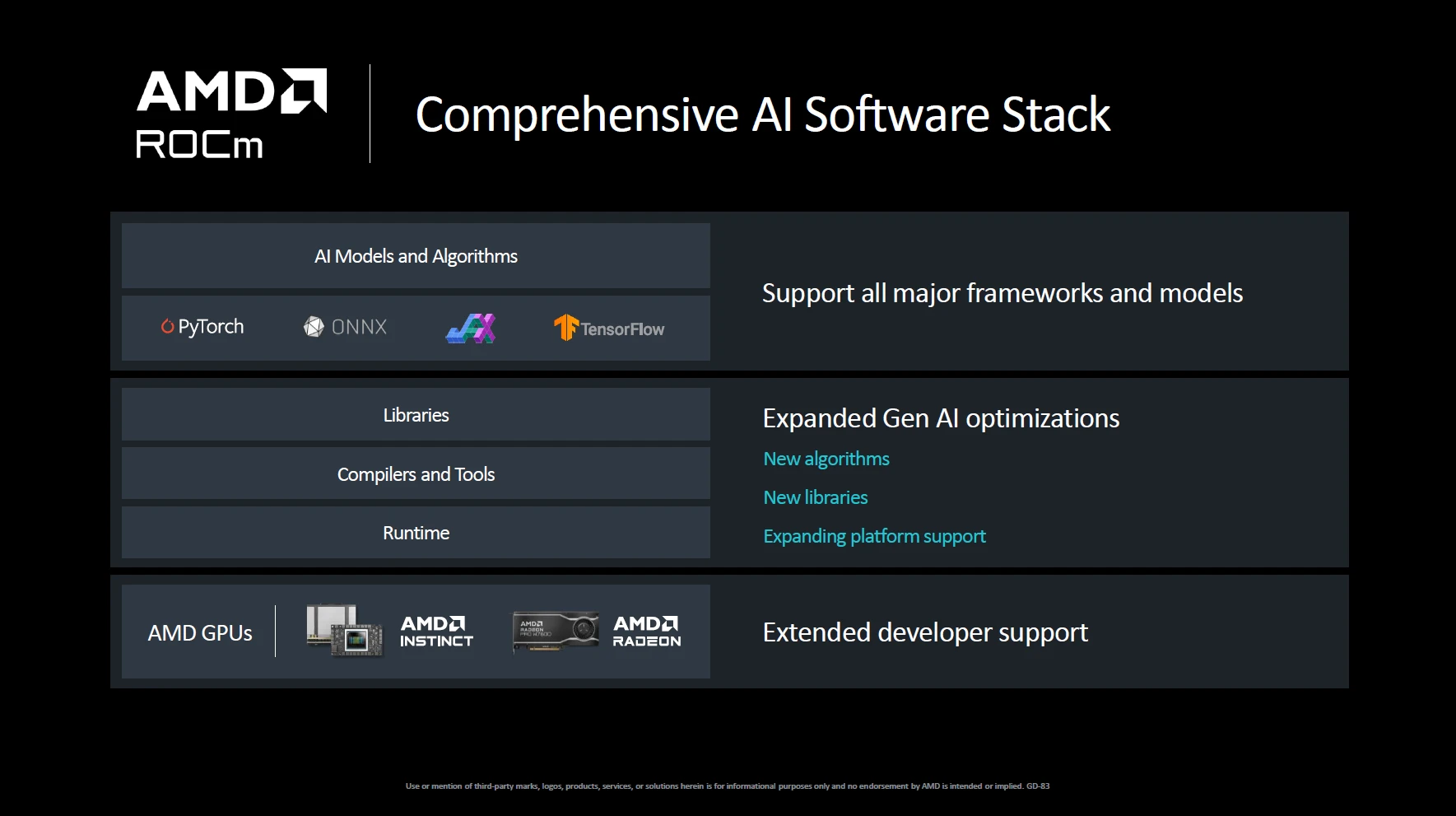

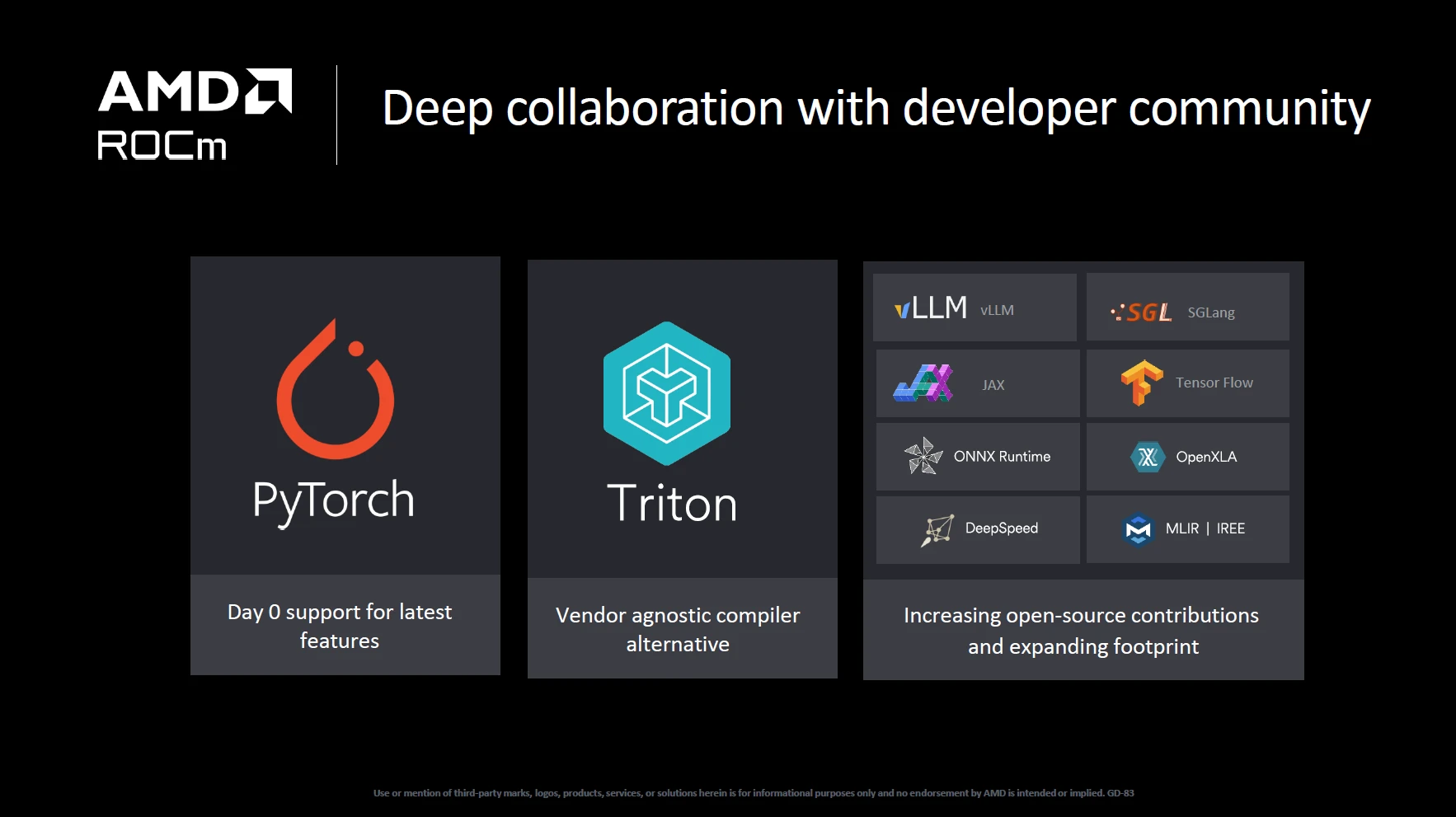

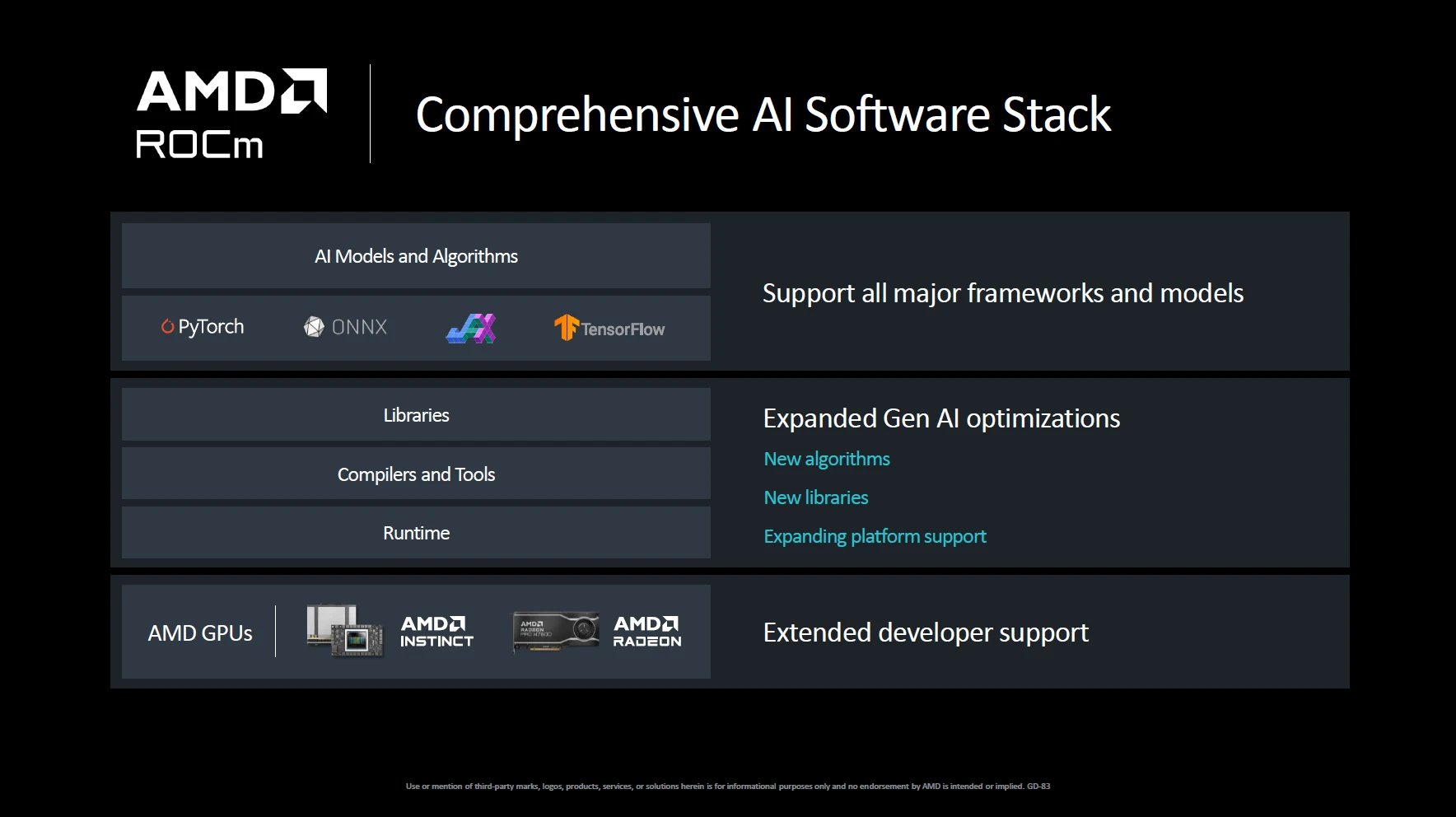

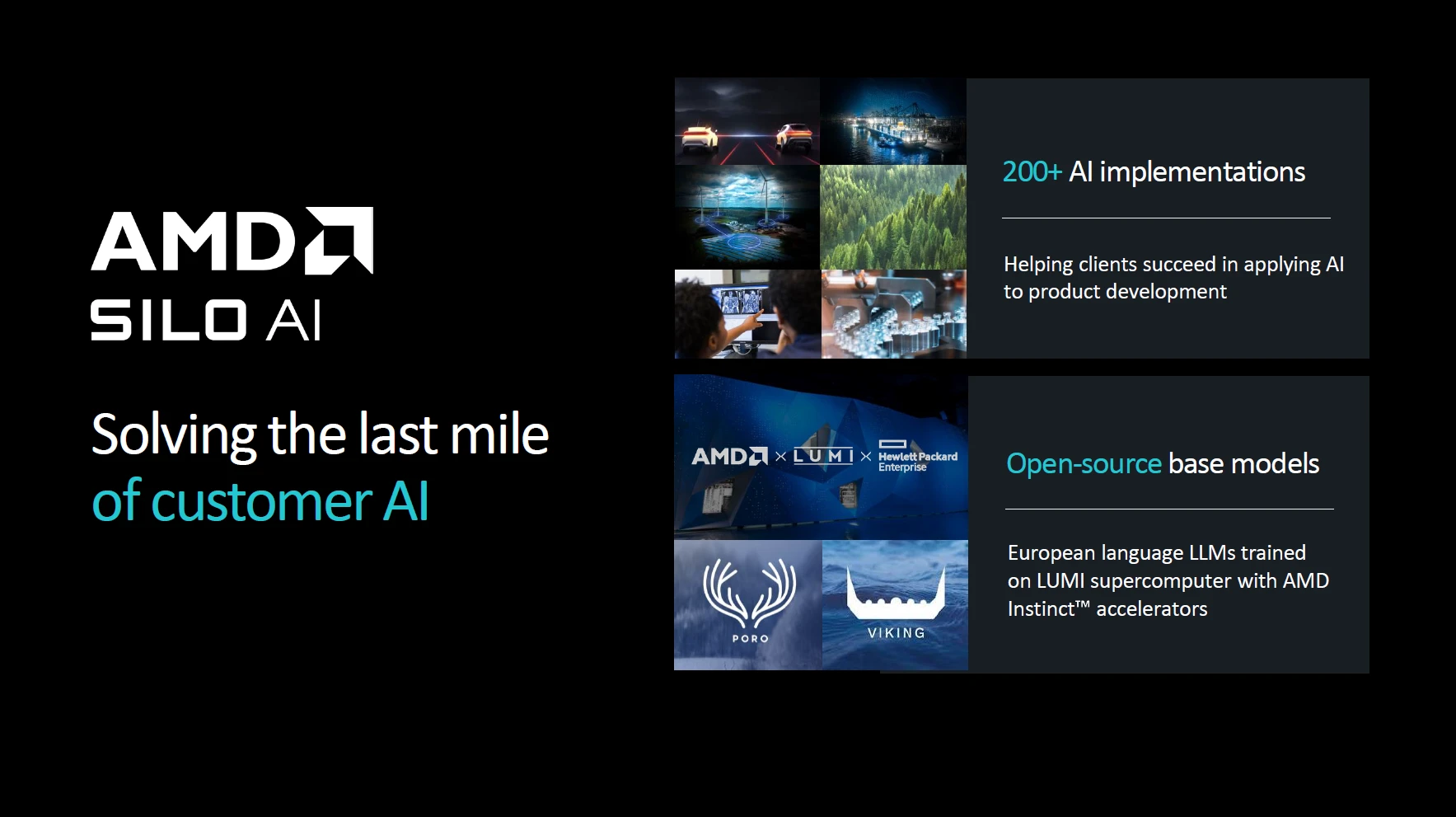

على صعيد الأداء، توفّر البيئة البرمجية الشاملة AMD ROMC زيادة تصل إلى الضعف في نتائج الاستدلال والتدريب مقارنة بالسابق، مع ما يزيد عن مليون نموذج ذكاء اصطناعي. كما أنها تتمتّع الآن بتعاون وطيد مع بيئات ومكتبات الذكاء الاصطناعي الشهيرة، مثل TensorFlow وONNX وOpenAI وغيرها؛ وذلك بالطبع بفضل تمكين تقنيات AMD Silo AI.

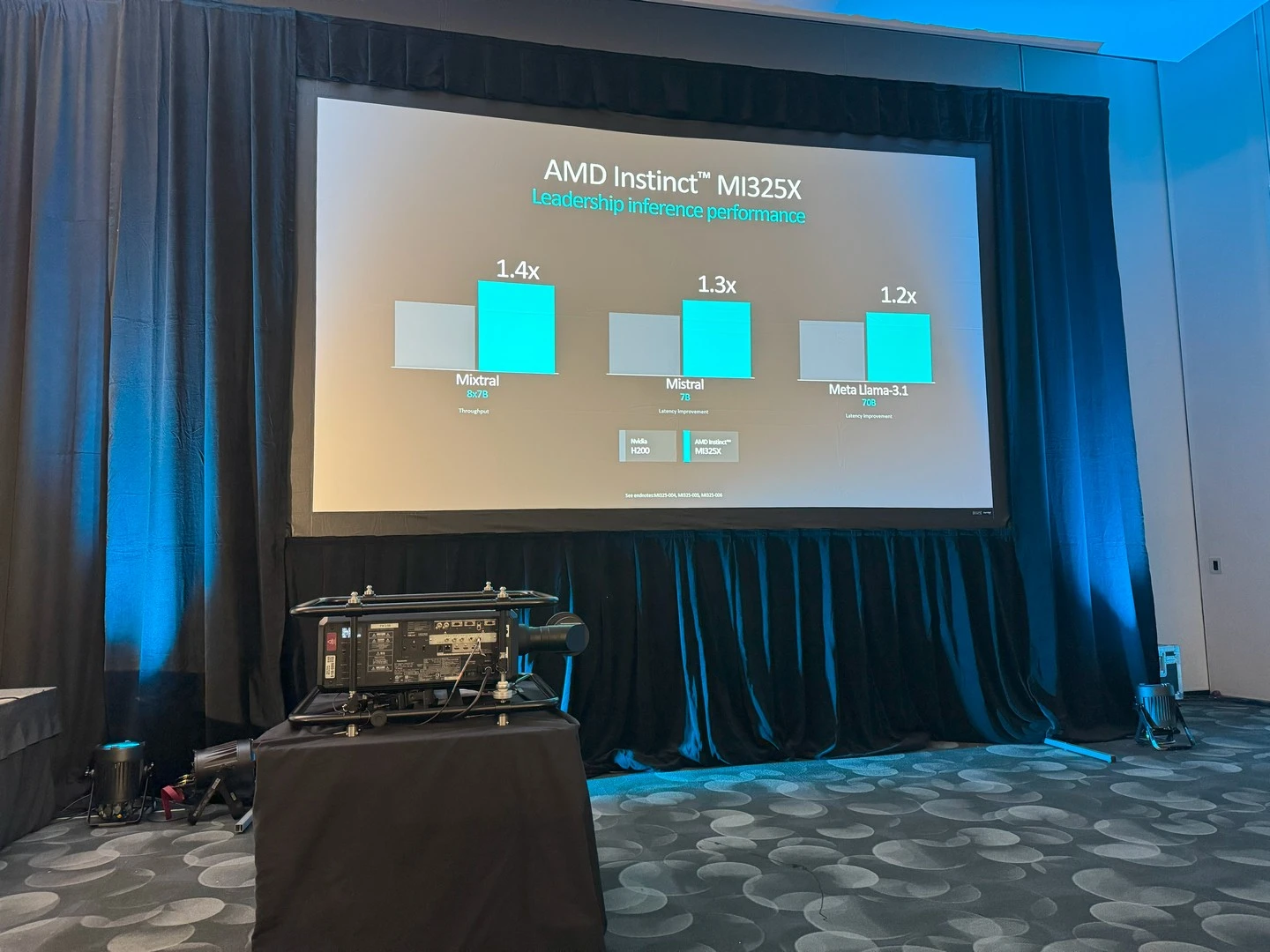

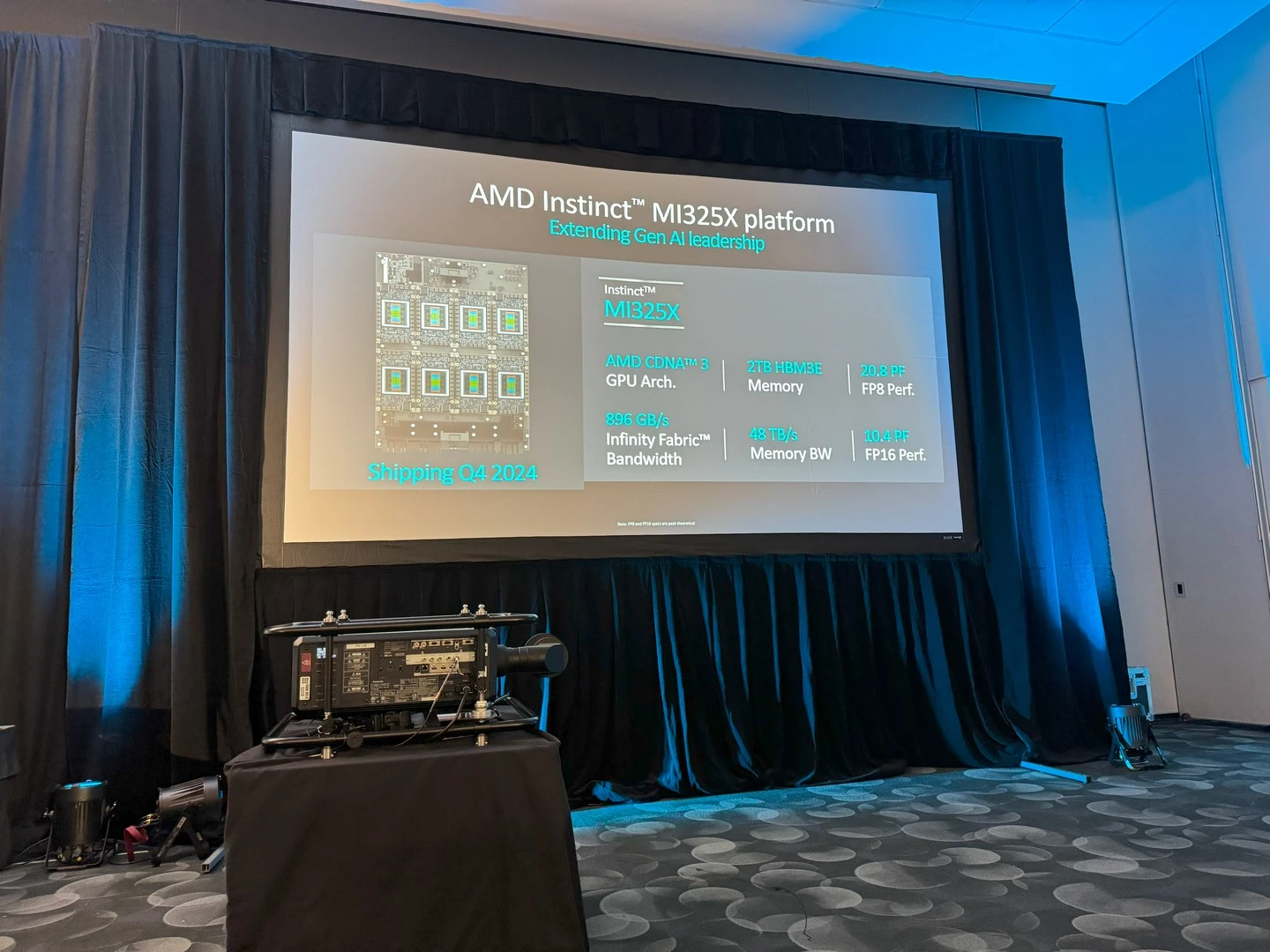

الإعلان عن مُسرّعات AMD Instinct MI325X للذكاء الاصطناعي

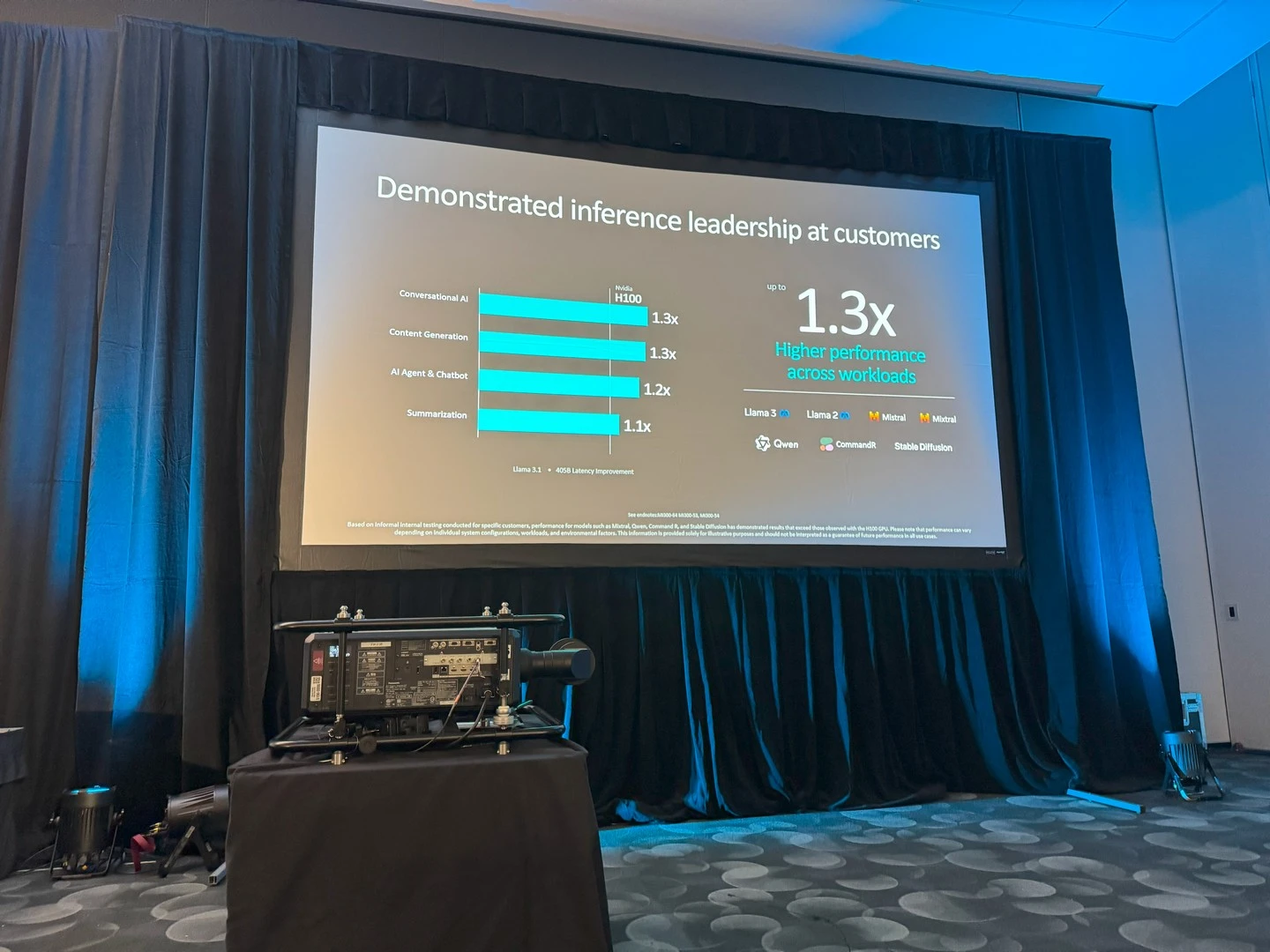

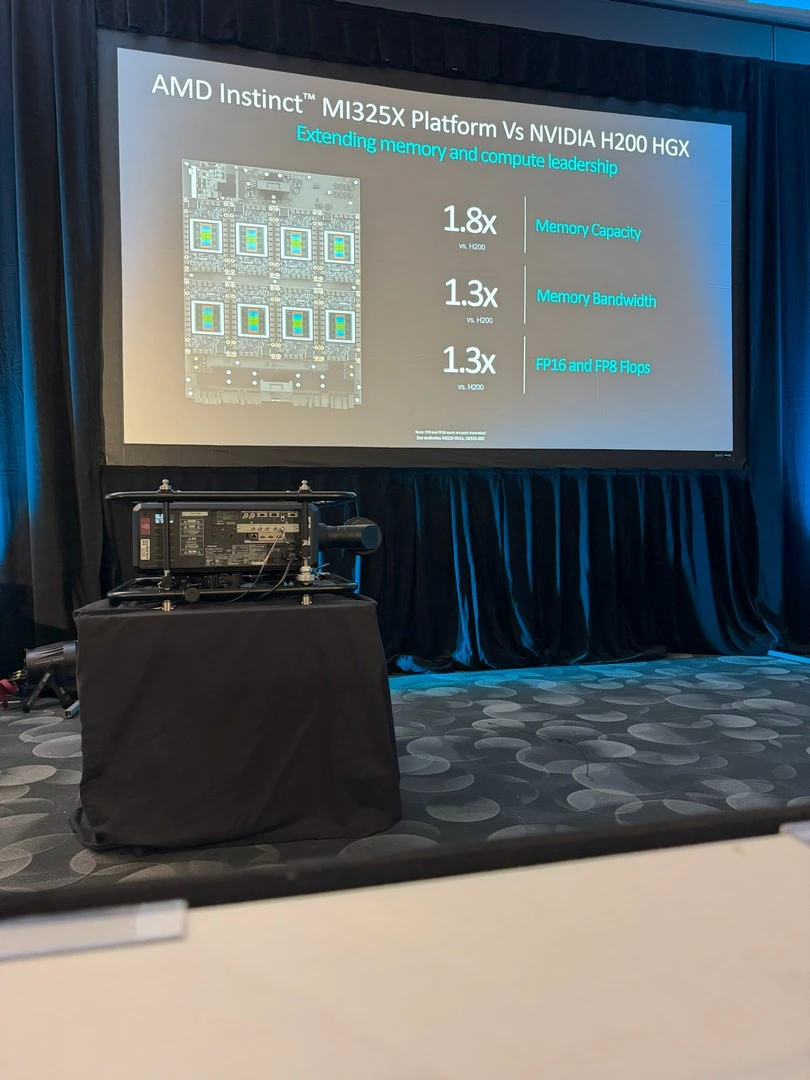

أعلنت AMD أيضًا عن مجموعة من المُنتجات الجديدة ضمن هذه السلسلة، مثل مُسرّع MI325X الجديد، الذي يعتمد على بنية CDNA 3 وذاكرة HBM3E بسعة 256GB، ومجموعة من التحسينات على صعيد التعليمات المدعومة كما يظهر في الصورة. هذه التحسينات بدورها أدّت إلى زيادة في الأداء بنسبة تصل إلى 30% في بعض الحالات مقارنةً بحلول H200 المُنافسة.

أما إذا كنت تبحث عن أداء أعلى، فيُمكنك التوجّه إلى منصّات MI325X التي تضم ثماني وحدات MI325X مرتبطة فيما بينها بروابط Infinity Fabric الجديدة فائقة السرعة، وذلك لتوفير عرض نطاق ترددي كبير بين الوحدات والحصول على نتائج نهائية أفضل. كما أنها تُقدّم قدرات تقنية أعلى بفارق ملحوظ مقابل المُنافسة؛ سواء كان ذلك على صعيد مستويات الاستدلال، أو حتى التدريب. وستتوفر منصّات MI325X كوحدات مُنفصلة أو ضمن منصّات كاملة بدايةً من الربع الأول من العام القادم 2025.

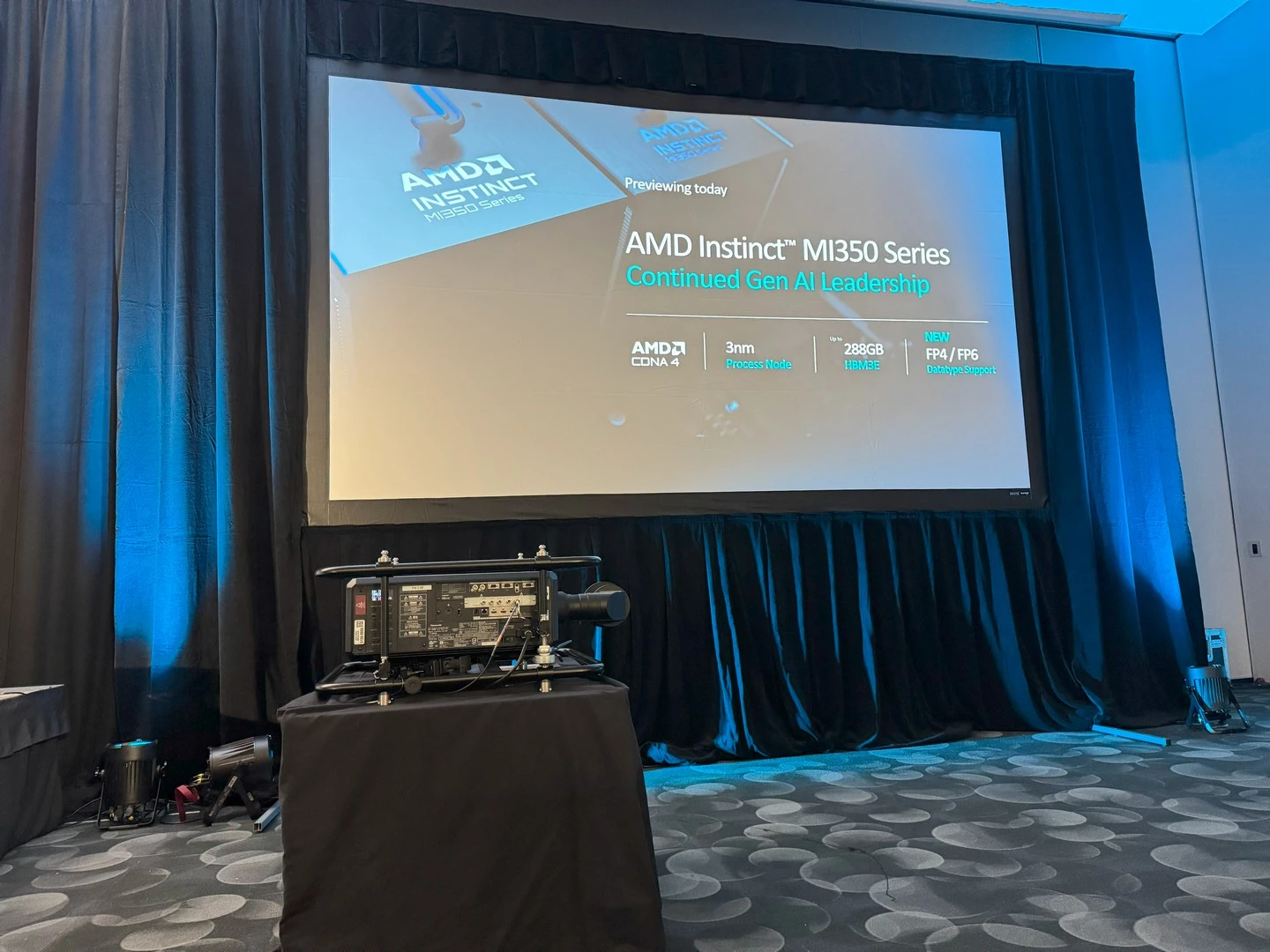

سلسلة AMD Instinct MI350

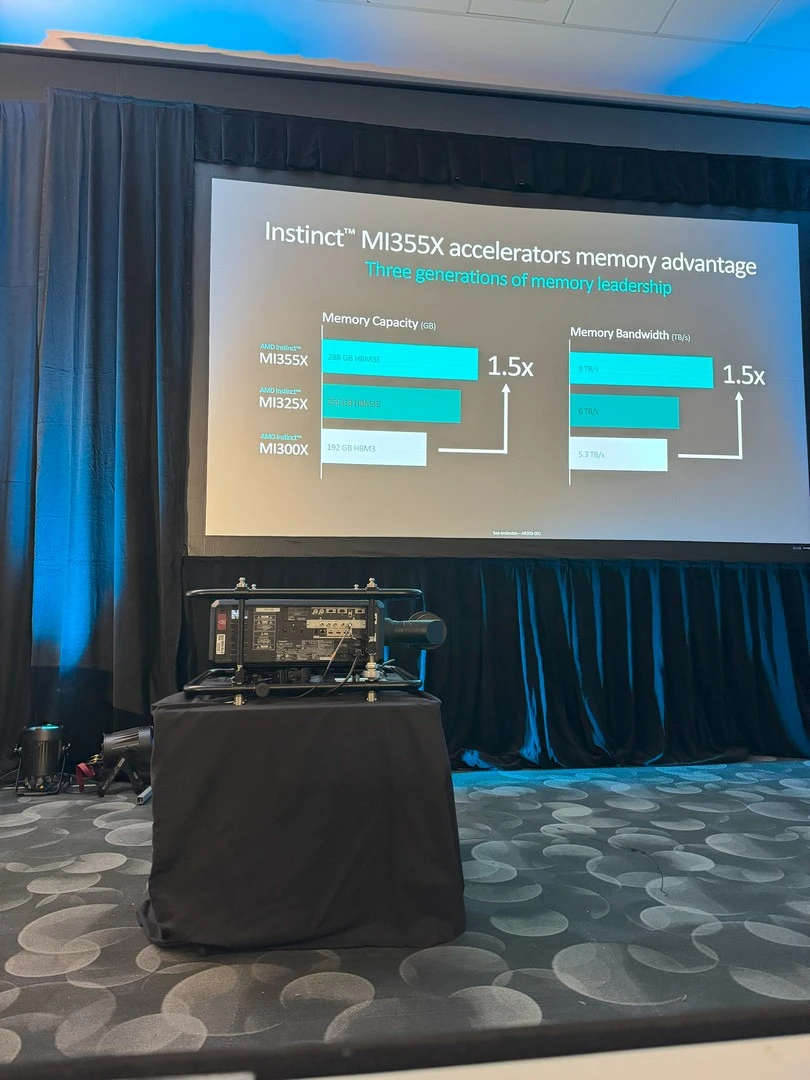

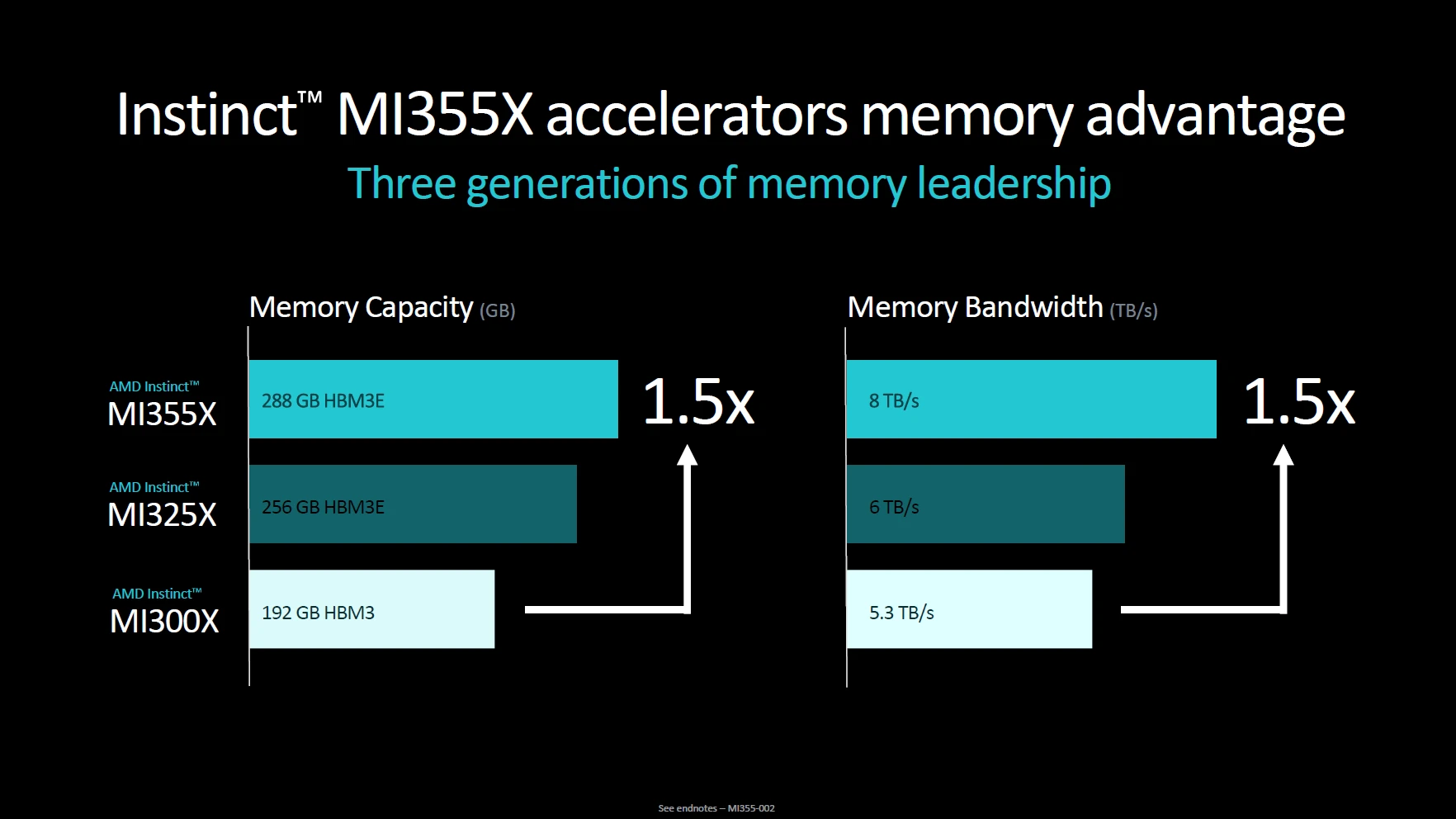

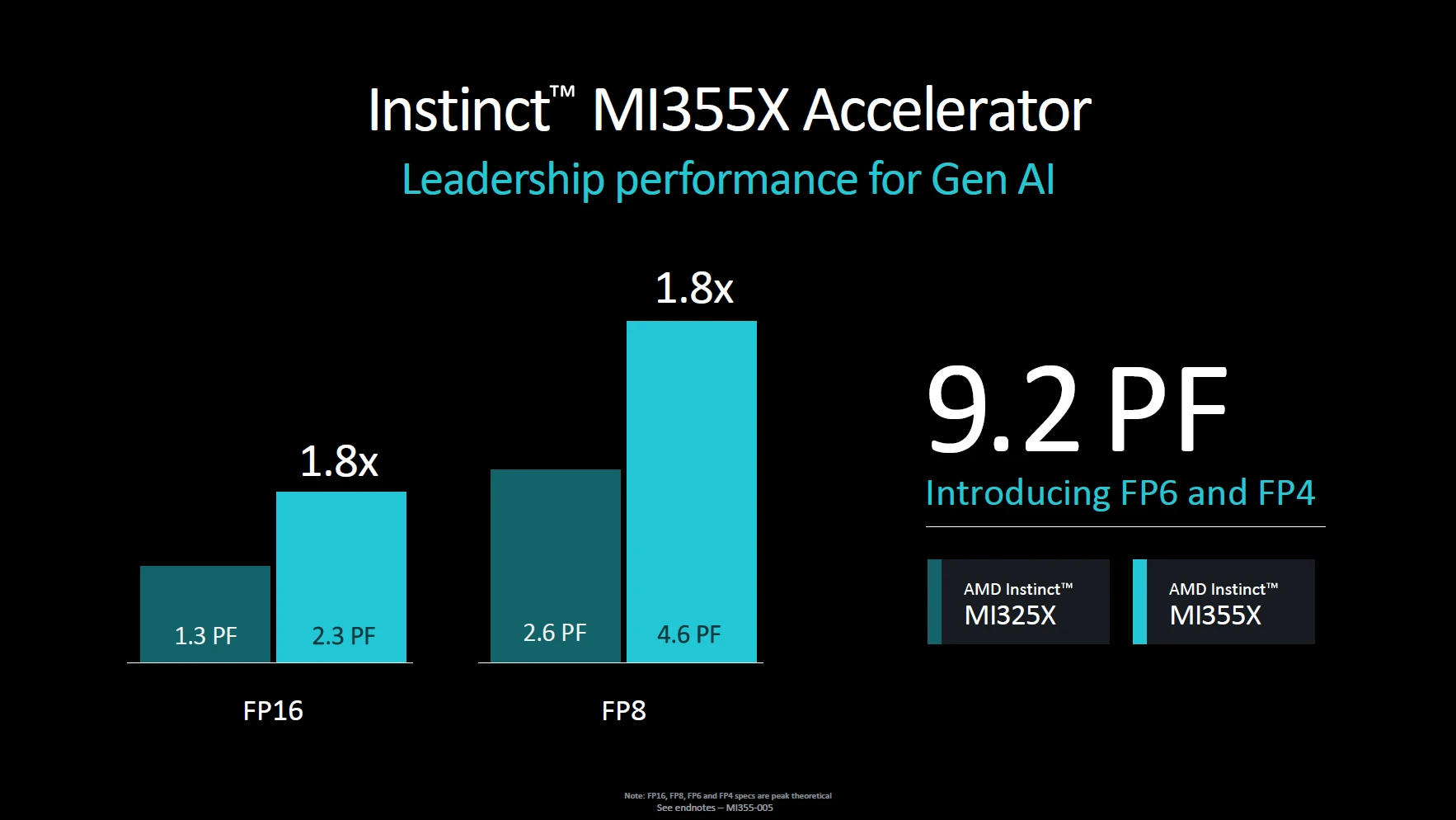

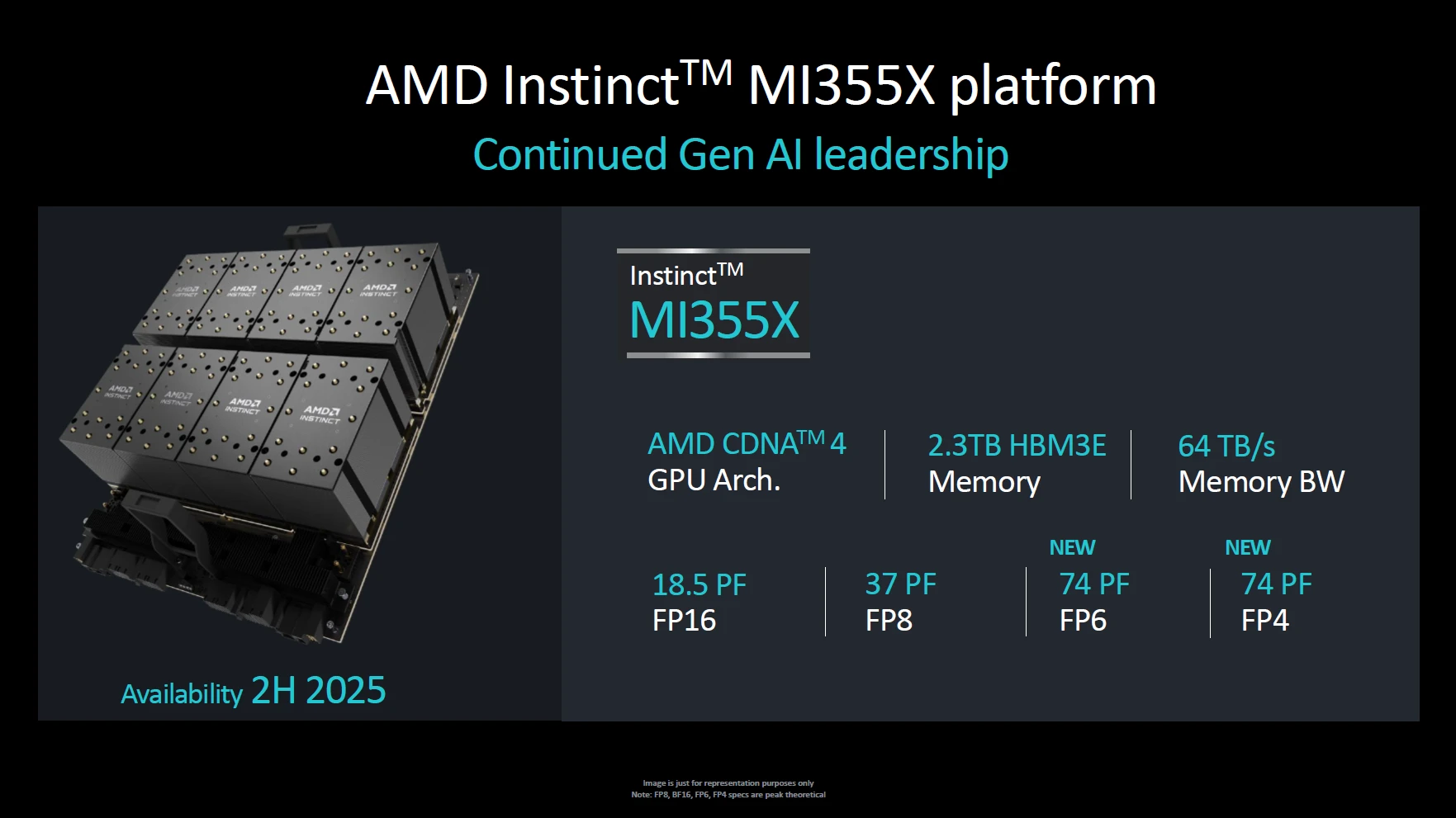

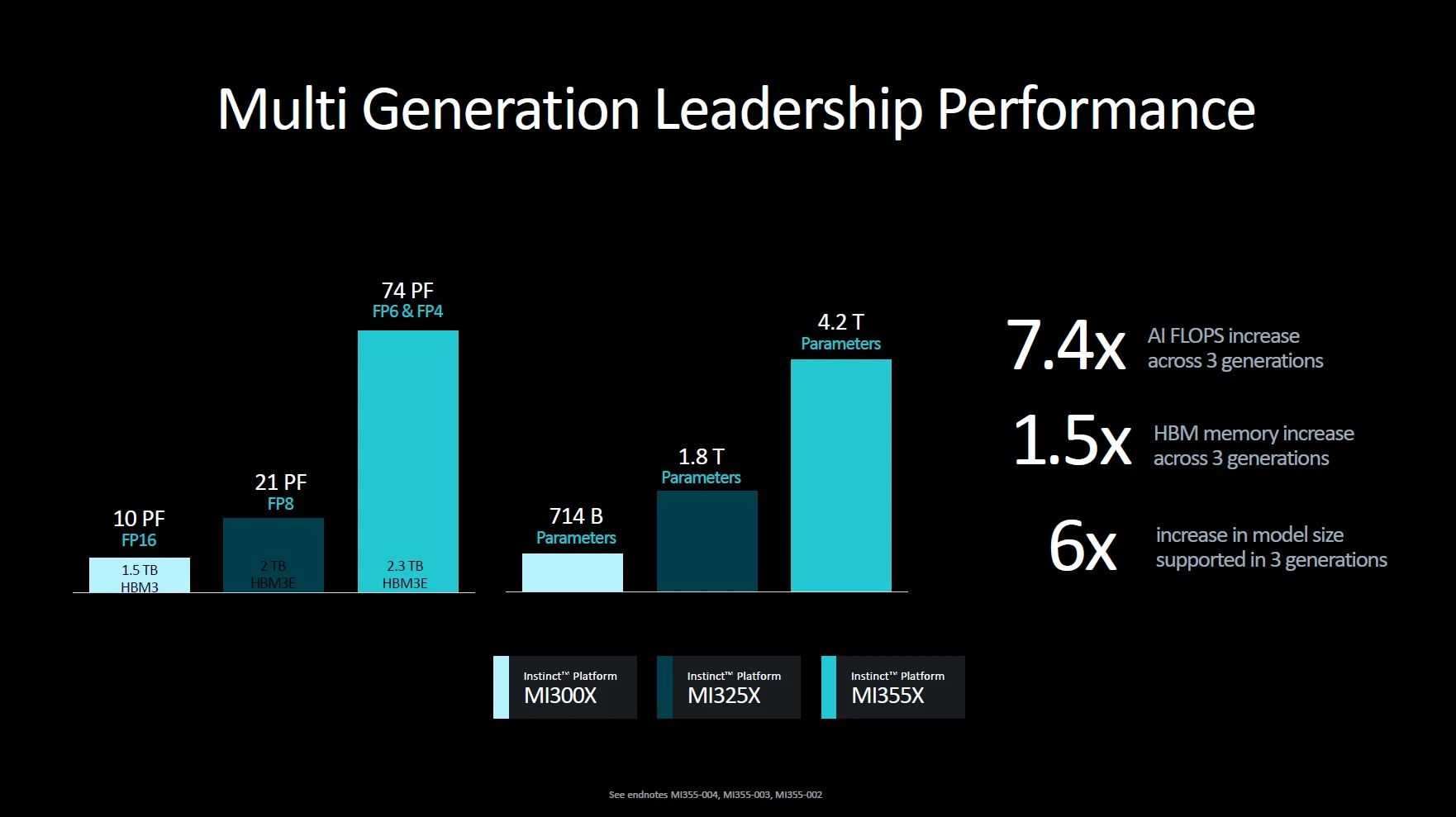

كل هذا جيد، ولكن دعونا نتحدّث قليلًا عن الجيل التالي من مُسرّعات الذكاء الاصطناعي من AMD، التي ستستخدم بنية CDNA 4 الجديدة، ومعمارية تصنيع 3nm؛ مع ما يصل إلى 288GB من ذاكرة HBM3E، ودعم جديد لتعليمات FP4/FP6. وبهذا يُقدّم هذا الجيل الجديد تحسينات على جميع الأصعدة تقريبًا، بدايةً من معمارية التصنيع المُحسّنة والتي تنعكس على استهلاك الطاقة والحرارة. مرورًا بالذاكرة الأكبر، ذات عرض النطاق الترددي الأعلى؛ ووصولًا للدعم البرمجي الأفضل.

كل هذا يعكس التطور الكبير الذي شهدته أجيال مُسرّعات AMD على طول السنوات الأخيرة، والأجيال الماضية.

واحد من أعضاء هذه السلسلة المميزين هو مُسرّع MI355X، الذي يأتي مع قدرات مُعزّزة على شكل وحدات مُنفردة أو ضمن منصّة كاملة توفّر ذاكرة HBM3E بسعة 2.3 تيرابايت، و 64TB/s من عرض النطاق الترددي، مع وصلات Infinity Fabric فائقة السرعة. وتستطيع هذه المنصّة توفير قدرات حوسبة مهولة مع التعليمات المُختلفة مُقارنةً بالأجيال الماضية، كما يظهر في الصورة.

أمّا بالنسبة للجيل التالي من AMD Radeon Instinct MI400، فيُتوقّع ظهوره في وقتٍ ما من عام 2026، حيث سنرى معه جيلًا جديدًا من معمارية CDNA، ودقّات التصنيع الأكثر دقّة وتطوّر.

تحسينات نظام AMD ROCm مفتوح المصدر

لا شك أن العتاد القوي يحتاج لبيئة عمل برمجية بنفس الرُقي ليوفّر مستويات الأداء الأمثل المُتوقّعة منه عند التعامل مع أحمال العمل المُختلفة الموجّه لها. ولأجل تحقيق هذه الغاية، يعمل نظام وبيئة AMD ROCm -مفتوح المصدر من AMD- على توفير الدعم الكامل بشكل دوري مُحسّن لنماذج وتطبيقات الذكاء الاصطناعي التوليدي المُختلفة، مع دعم أحدث الخوارزميات والمكتبات، والنماذج العالمية الشهيرة للتوافق مع بيئة منتجات AMD.

ومع دعم المزيد والمزيد من المكتبات والمطورين بشكل مُستمر لمجموعة مُنتجات AMD، تستطيع الشركة توفير بيئة العمل الأنسب لعُملائها. كما أن التركيز على دعم النماذج والبيئات مفتوحة المصدر، يعني عدد أكبر من المُطوّرين، ومستويات أفضل من التحسين، ودعم أفضل وأكثر سهولة للعُملاء و المُستخدمين.

كل ذلك مع تحسين في مستويات الأداء بين أجيال بيئة ROCm نفسها، مما يوفّر مستويات أداء أفضل، ويفتح المجال أمام استقطاب المزيد من العُملاء والمُستخدمين؛ لتوفير حلول الذكاء الاصطناعي السهلة التي يبحث عنها العُملاء حول العالم.

الجيل التالي من الشبكات الذكية AI Networking

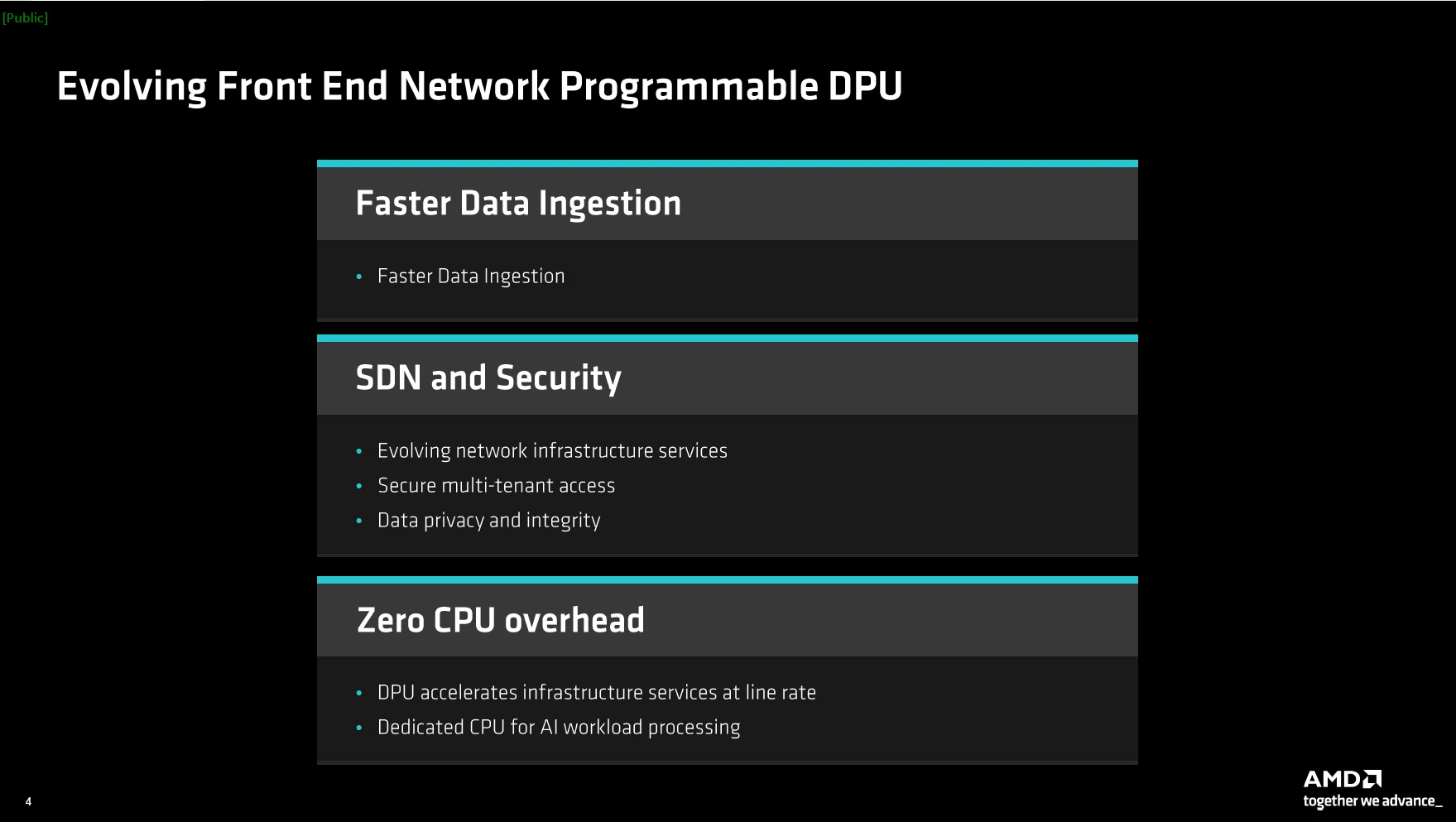

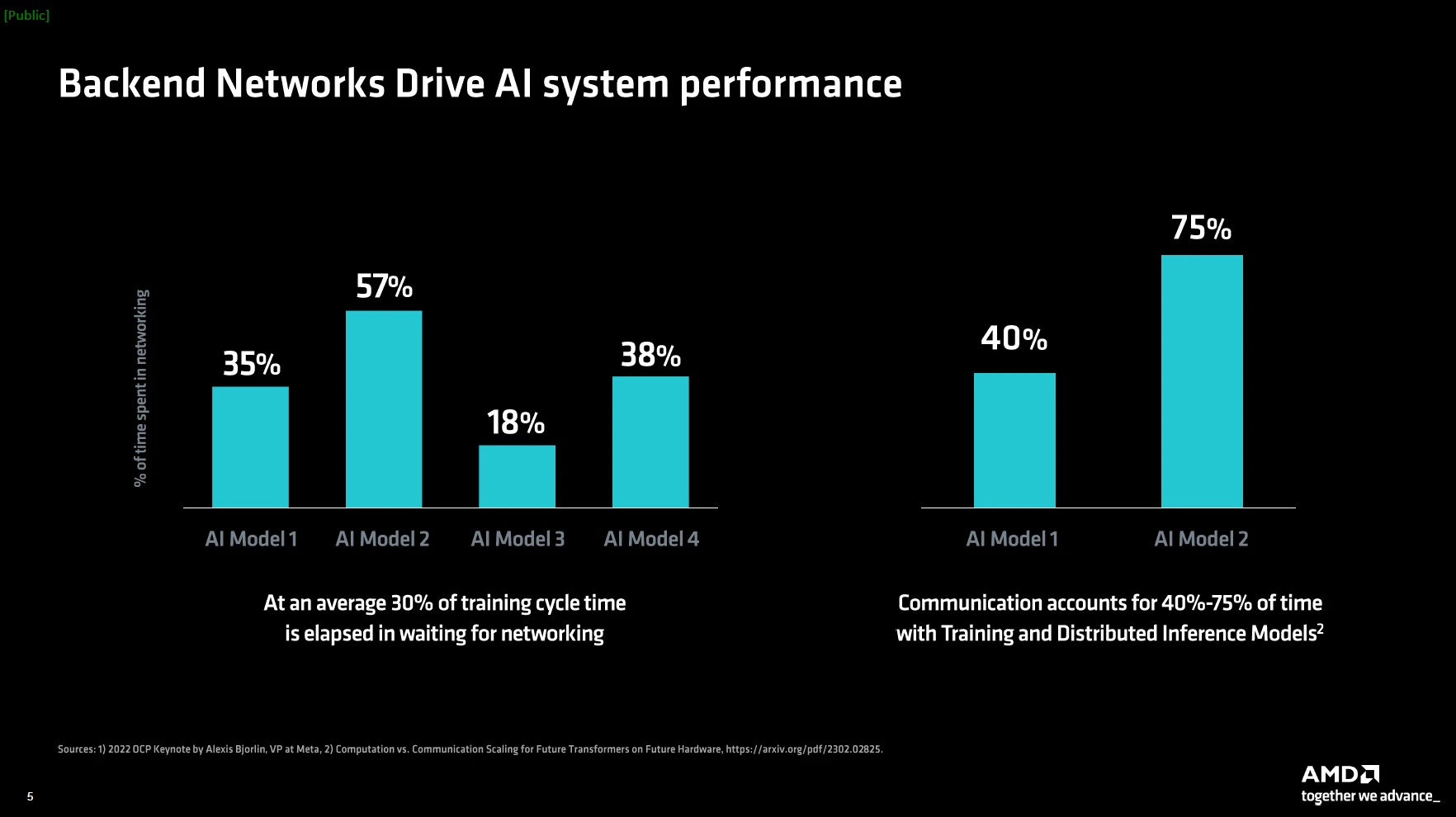

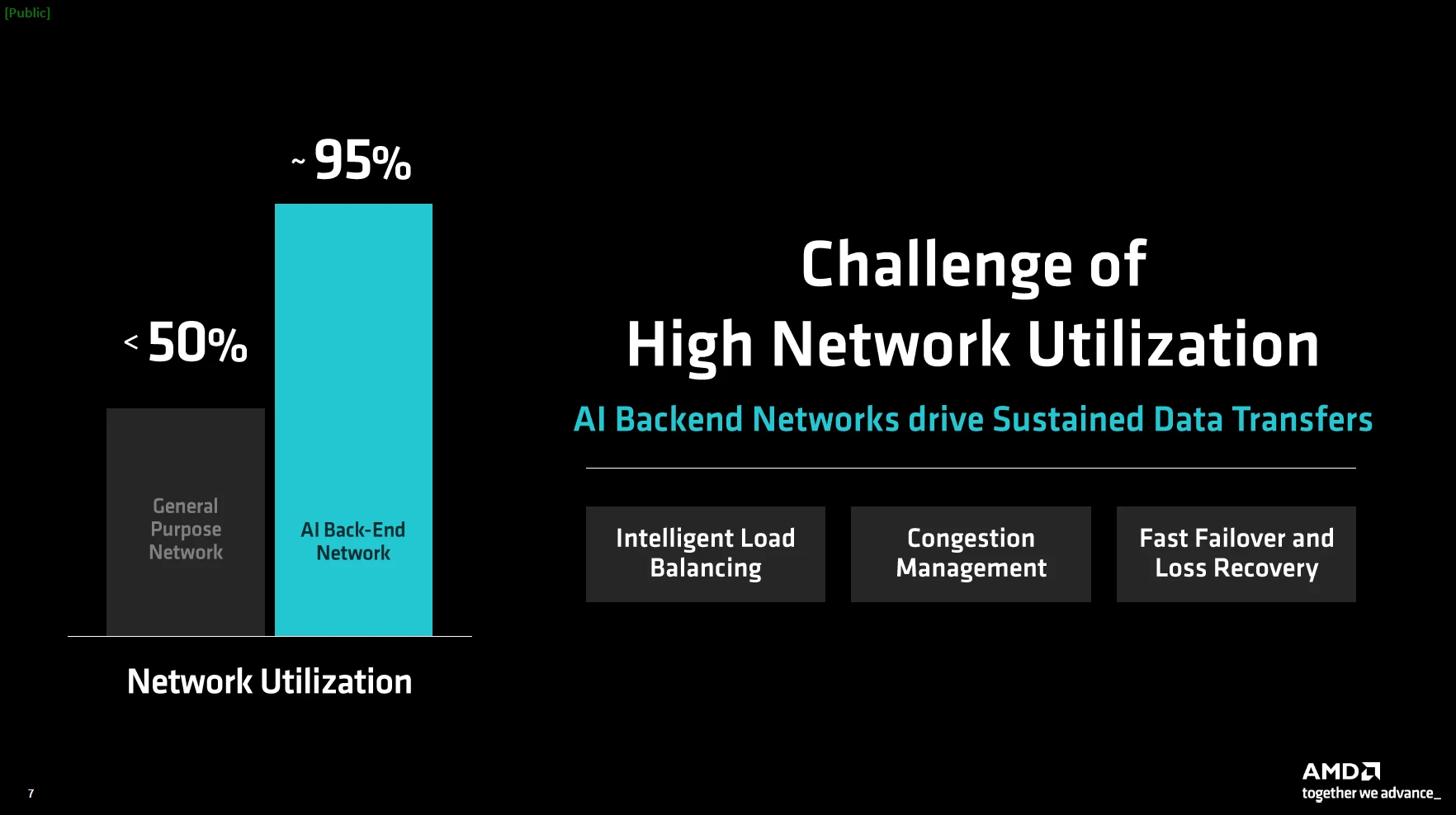

لتقديم تجربة مراكز البيانات الأفضل، تستفيد AMD هذه المرّة من واحدة من أكثر وحدات معالجة البيانات القابلة للبرمجة (DPU أو Data Processing Units) انتشارًا على نطاق واسع في مراكز البيانات وأجهزة الكمبيوتر العملاقة لتشغيل شبكات الذكاء الاصطناعي من الجيل التالي، والتي بدورها تُعتبر واحدة من أهم المكونات الأساسية لمراكز البيانات المُخصّصة للذكاء الاصطناعي في الوقت الحالي.

للتوضيح، تنقسم شبكات الذكاء الاصطناعي إلى قسمين: الواجهة الأمامية، التي توفر البيانات والمعلومات لمجموعة من أجهزة الذكاء الاصطناعي. والواجهة الخلفية، التي تدير نقل البيانات بين المسرعات ومجموعات الأجهزة.

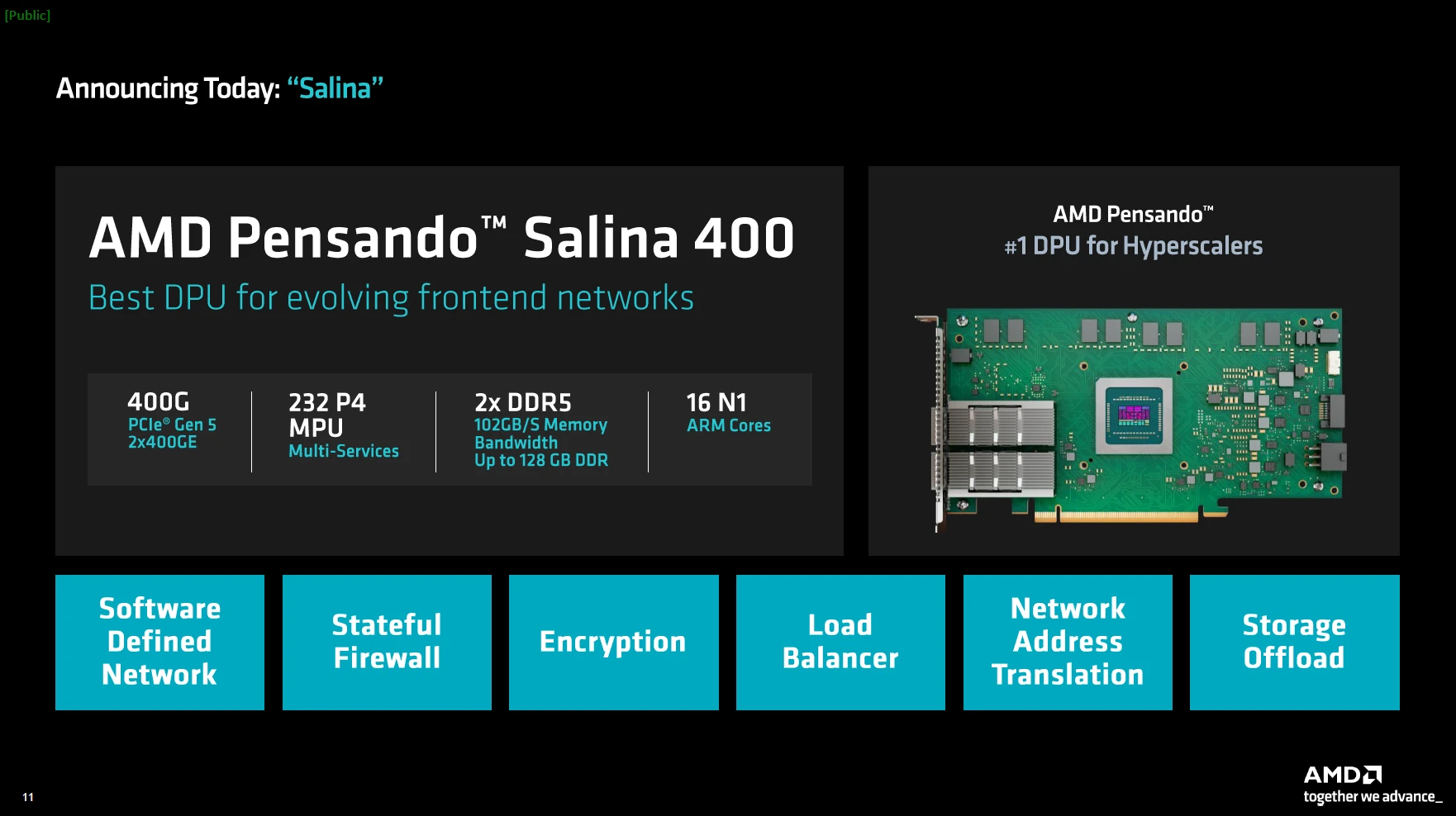

وحدات معالجة البيانات AMD Pensando Salina

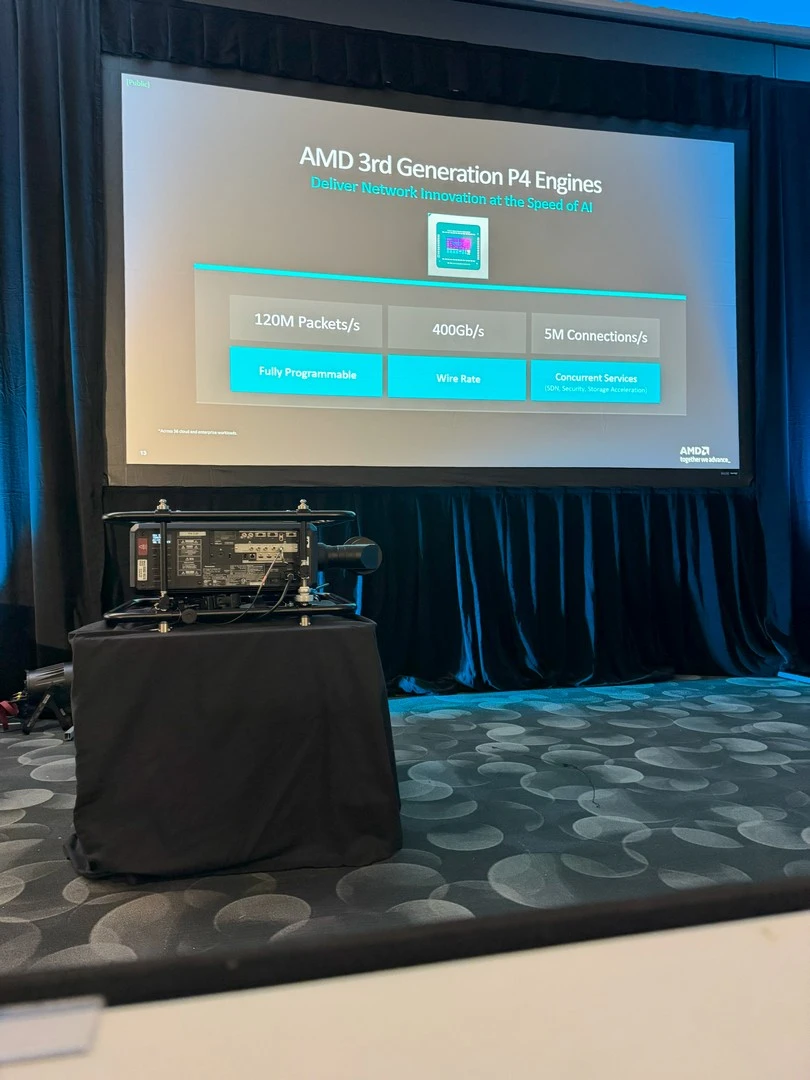

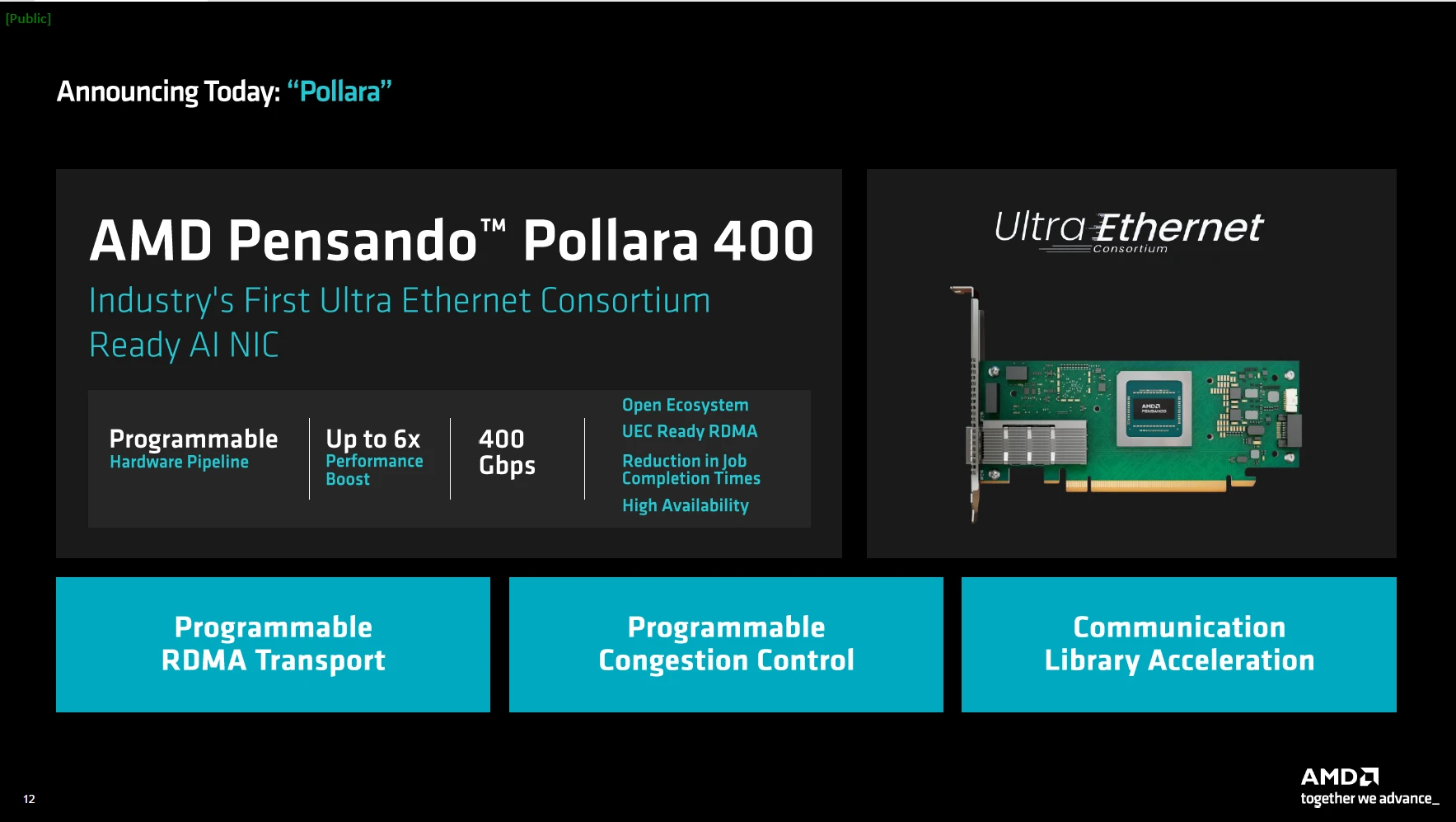

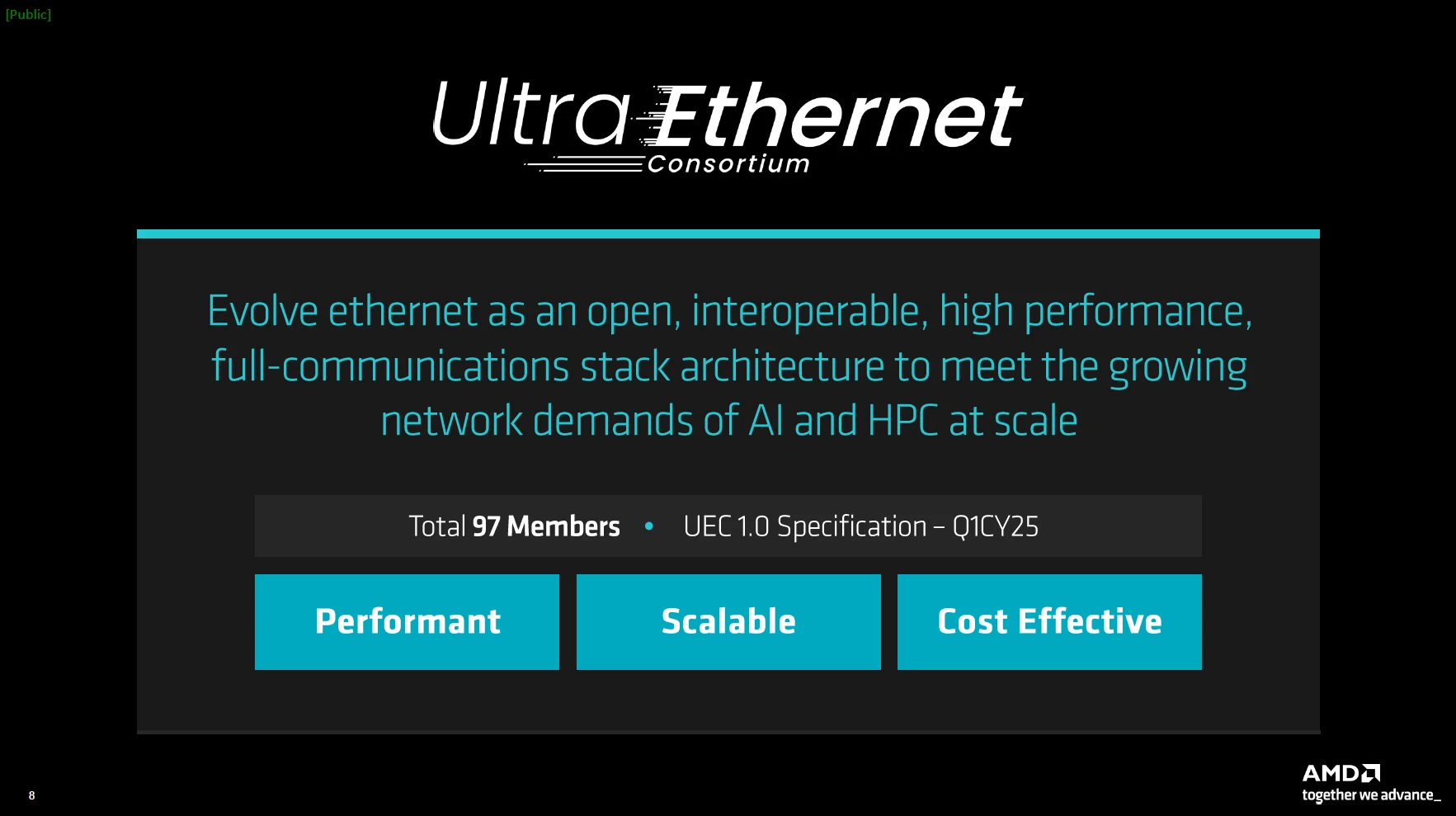

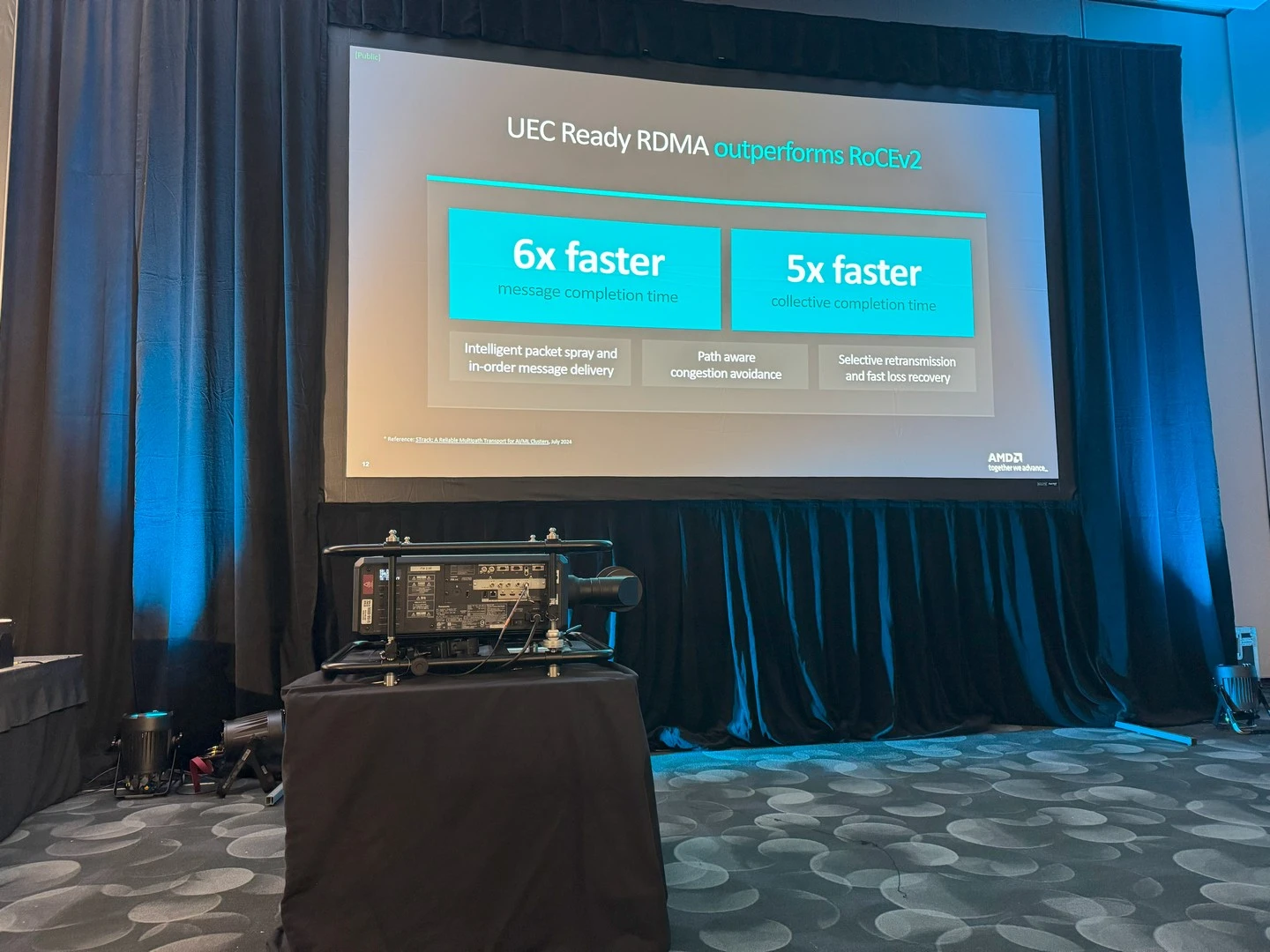

هنا يأتي دور وحدات معالجة البيانات AMD Pensando Salina الجديدة من AMD، المُخصّصة للواجهات الأمامية وAMD Pensando™ Pollara 400 المُوجّهة للواجهة الخلفية. تُعتبر أول بطاقة شبكة ذكاء اصطناعي متوافقة مع معيار UEC في الصناعة.

تأتي وحدات معالجة البيانات AMD Pensando Salina في جيلها الثالث كواحدة من أكثر وحدات معالجة البيانات أداءً وقابلية للبرمجة في العالم، حيث توفر أداءً ونطاق ترددي وحجمًا أكبر بمقدار الضعف مقارنة بالجيل السابق. حيث تُقدّم معدل نقل بيانات يبلغ 400Gbps، مما يجعل وجودها أساسي في مجموعات شبكات الواجهة الأمامية للذكاء الاصطناعي.

كما أنها تأتي مع العديد من التقنيات التي تعمل على تحسين الكفاءة والأمان والأداء؛ بجانب مُضاعفة الأداء الخاصة بأعمال بالذكاء الاصطناعي الذي يعتمد على البيانات.

بطاقات الشبكة AMD Pensando Pollara 400

مع التطوّر المُستمر لسرعات الإنترنت، والحاجة المُتزايدة للحصول على اتّصالات قويّة وثابتة، تستمر AMD بشكل دؤوب في ابتكار وتحسين تقنياتها لتقديم أفضل بيئة عمل تكاملية مُمكنة.

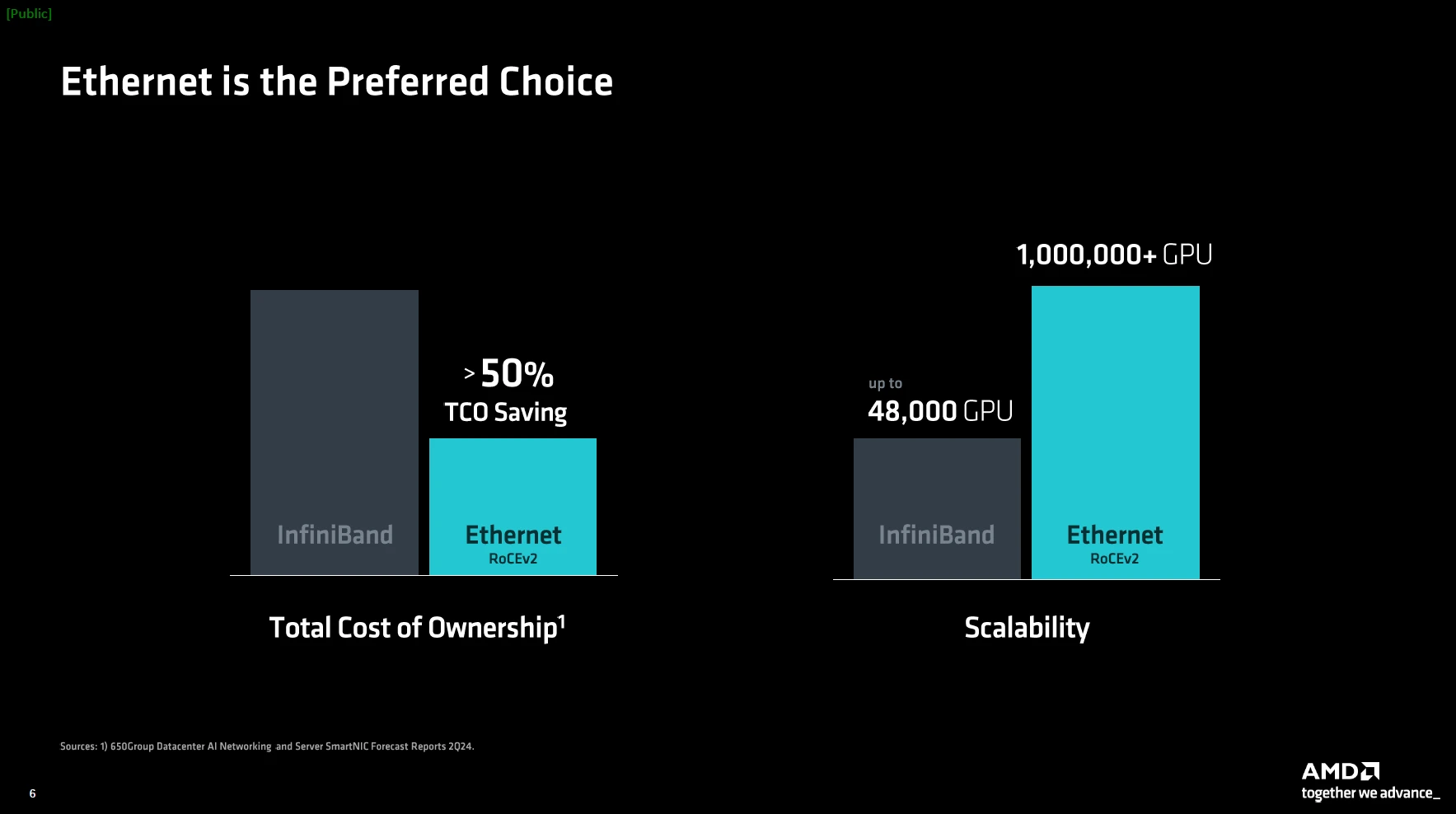

وبناءً على تفوّقها في سوق الخوادم مع مُسرّعات Instinct، ومعالجات AMD EPYC، تُقدّم AMD بطاقات Pensando Pollara 400. تُعد أول بطاقة شبكة داعمة لمعيار UEC، مع دعم لبرمجيّات RDMA وبيئتها مفتوحة المصدر، وتستفيد من قُدرات مُحرك AMD P4 القابل للبرمجة. مما يجعلها حجر بناء أساسي في الشبكات الخلفية لتوفير أداء قوي، واتّصال موثوق بين المُسرّعات، وقابلية تطوير مستمرة.

ستتوافر كل من وحدات معالجة البيانات AMD Pensando Salina، و بطاقات Pensando Pollara 400 في النصف الأول من عام 2025.

استعد بالشكل الأمثل لعصر الذكاء الاصطناعي مع AMD

كما نرى، تسعى AMD بشكل دائم للالتزام بتوفير أحدث المُنتجات، والتقنيات الحديثة التي تخدم مُستخدميها وعُملائها في الأسواق المُختلفة، ضمن بيئة عمل مُتكاملة على الجانب العتادي والبرمجي على حدٍ سواء.

الأمر الذي رأيناه اليوم في حدث AMD Advancing AI، الذي يُركّز بوضوح على توفير أفضل الحلول الموجّهة لبيئات عمل الذكاء الاصطناعي، سواء على صعيد المُنتجات (مثل مُسرّعات Instinct، ووحدات معالجة البيانات AMD Pensando Salina، وبطاقات الشبكات Pensando Pollara 400)، أو بيئات العمل مفتوحة المصدر AMD ROCm.