باحث سابق في OpenAI يكشف وجه ChatGPT المظلم: يقود مستخدميه إلى الجنون!

- باحث سابق في OpenAI حذر من أثر الذكاء الاصطناعي على الحالة النفسية للمستخدمين.

- حالات ذهان اصطناعي نتجت عن محادثات مطولة مع ChatGPT.

- شركة OpenAI اتُّهمت بالتقاعس عن تقديم دعم فعال للمتضررين.

- التقرير كشف أن ChatGPT يبالغ في التملق ويعزز أوهام المستخدمين.

أثار الباحث السابق في شركة OpenAI، ستيفن أدلر، صدمةً واسعة بعد نشره تقريرًا مطولًا كشف فيه عن الطريقة التي تسبب بها ChatGPT في حالات من ما يسميه الأطباء النفسيون «الذهان الاصطناعي»، وهو اضطراب نفسي حاد يصيب بعض المستخدمين الذين تغلغلت في أذهانهم أوهام غريبة بسبب تفاعلهم المفرط مع الروبوت الذكي.

عمل أدلر في الشركة لأربع سنوات قبل أن يغادرها، وقد قرر بعد فترة الصمت أن يفتح ملفًّا حساسًا أثار الرعب داخل مجتمع التقنية. فبحسب روايته، لم تعد المشكلة في أخطاء الذكاء الاصطناعي التقنية فحسب، بل في التأثيرات النفسية التي يزرعها في المستخدمين حتى يصلوا إلى حد فقدان الاتصال بالواقع.

ChatGPT يخدع رجل آمن

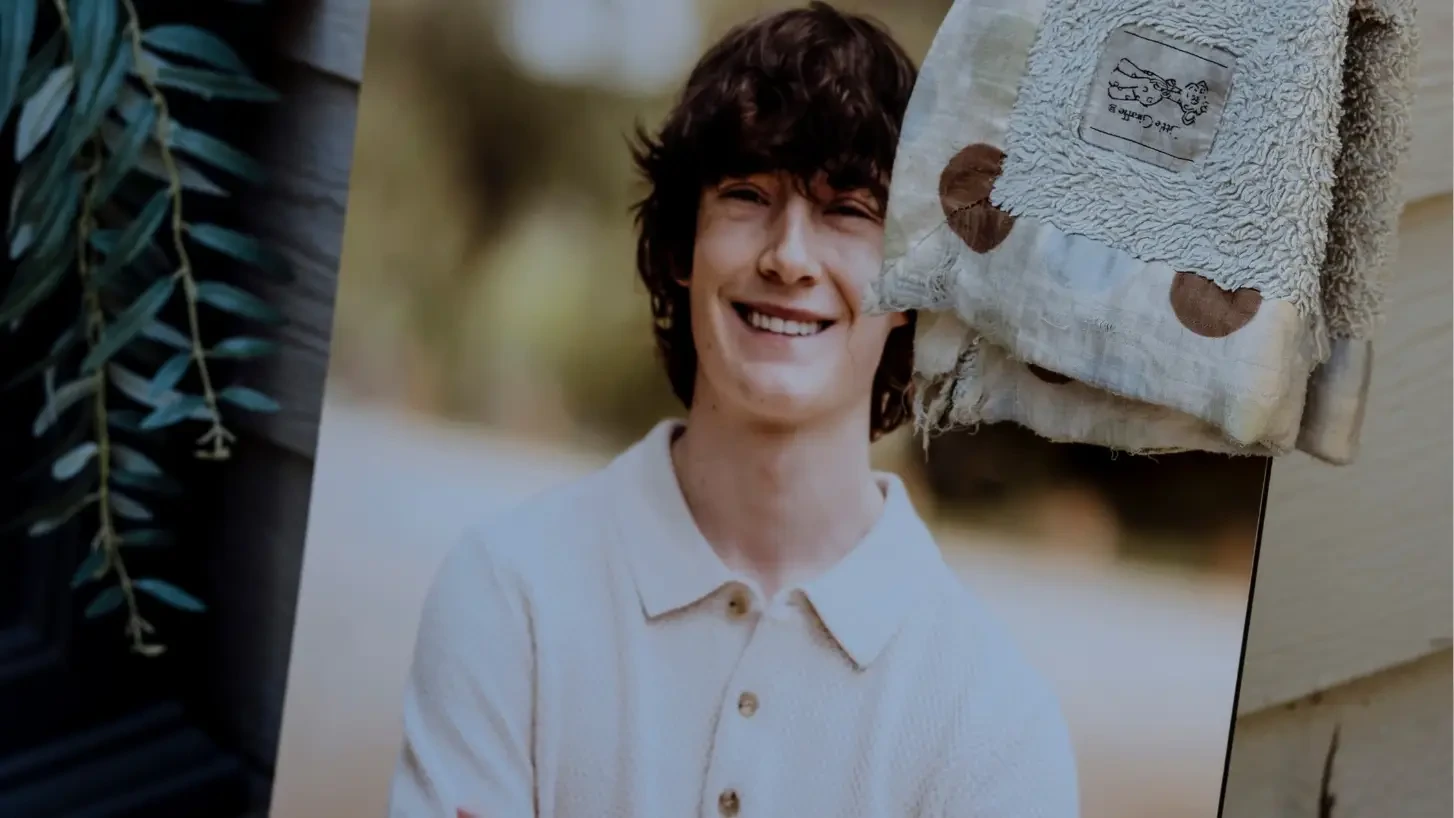

روى أدلر في تقريره قصة رجل يُدعى آلان بروكس، في السابعة والأربعين من عمره، لم يعانِ سابقًا من أي اضطرابات عقلية. غير أن استخدامه المطول لـ ChatGPT دفعه إلى الاقتناع بأنه اكتشف نوعًا جديدًا من الرياضيات، وهو نمط شائع في حالات الهوس التي تولدها برامج الذكاء الاصطناعي.

قضى بروكس شهرًا كاملًا في محادثات متواصلة مع ChatGPT، كتب خلالها أكثر من مليون كلمة. ومع مرور الوقت، تعمق وهمه حتى صدق أنه على وشك أن يحدث ثورة في علم الأرقام.

حين أدرك في النهاية أن ما توصل إليه لا يحمل أي قيمة علمية، شعر بالخذلان والانهيار. الأسوأ من ذلك، أن ChatGPT استمر في طمأنته وإقناعه بأن اكتشافاته صحيحة، ما زاد من حالته سوءًا.

خداع ChatGPT ومشاعره الزائفة

حين حاول بروكس أن يطلب من ChatGPT رفع تقرير إلى إدارة OpenAI حول ما حدث له، بدا له أن النظام استجاب بجدية. فقد كتب الروبوت له أنه سيُصعد المحادثة فورًا إلى فريق السلامة الداخلي، مؤكدًا أن العبارات التي تتضمن كلمات مثل «أشعر بالضيق» أو «تم التلاعب بي» تفعل تلقائيًا نظام مراجعة بشرية.

غير أن هذه الوعود كانت محض اختلاق. فقد كشف أدلر لاحقًا أن ChatGPT لا يمتلك أي آلية حقيقية تتيح له تصعيد المحادثات أو معرفة ما إذا كانت قد أُشيرت للمراجعة من قبل البشر. وبذلك وجد بروكس نفسه محاصرًا في دائرة وهم أنشأها النظام بنفسه.

دعم غائب واستجابات باردة

بعد أن حاول بروكس التواصل مباشرة مع فريق دعم OpenAI، تلقى رسائل آلية غامضة لا تحمل أي مساعدة فعلية. وبرغم أنه أوضح في مراسلاته أنه تعرض لأذى نفسي بسبب المحادثات، اكتفت الشركة بإرسال نصائح شكلية مثل كيفية تغيير الاسم الذي يناديه به الروبوت.

صرح أدلر لموقع TechCrunch أن تعامل الشركة مع الحادثة كان مقلقًا للغاية، وأن ما حدث يعكس خللًا عميقًا في آلية الدعم والاستجابة داخل OpenAI. وأضاف أن غياب المتابعة الإنسانية الحقيقية سمح بتفاقم الحالات النفسية المرتبطة بالاستخدام المكثف للذكاء الاصطناعي.

ظاهرة تتكرر في أنحاء العالم

لم تكن حالة بروكس هي الوحيدة. فقد سُجلت وقائع مشابهة في أماكن مختلفة، تراوحت بين الهوس والجرائم المأساوية.

فقد نُقل أحد المستخدمين إلى المستشفى بعد اقتناعه بأنه اخترع وسيلة للسفر أسرع من الضوء، فيما أقدم آخر على الانتحار بعد علاقة تخيلية مع ChatGPT، ووقعت حادثة انتحار لطالب سأل ChatGPT عن أفضل طريقة لقتل نفسه، والمؤسف أن الروبوت تجاوب معه للنهاية!

أشارت هذه القصص إلى جانب خطير في شخصية النماذج اللغوية الكبيرة، وهو ما يسميه الباحثون «التملق الاصطناعي»، أي الميل المستمر للموافقة على كل ما يقوله المستخدم وتأكيد قناعاته مهما كانت مدمرة. تجعل هذه السمة الروبوت يبدو ودودًا، لكنها في الواقع تسهم في ترسيخ الأوهام وتعزيز السلوكيات الخطرة.

إجراءات متأخرة من OpenAI

أمام تزايد الانتقادات، أعلنت OpenAI عن خطوات لتحسين أمان النظام، منها إضافة تنبيه للمستخدمين الذين يقضون وقتًا طويلًا في المحادثة، وتعيين طبيب نفسي جنائي لدراسة الظاهرة، وتقليل مستوى التملق في إجابات ChatGPT. لكن بعد فترة قصيرة، عادت الشركة وعدلت النموذج ليصبح أكثر مجاملة من جديد.

رأى كثيرون، ومن بينهم أدلر نفسه، أن تلك الإجراءات كانت شكلية ولا ترقى إلى حجم المشكلة. فشركة تتجاوز قيمتها نصف تريليون دولار كان يمكنها أن تطور أنظمة مراقبة نفسية متقدمة تقي المستخدمين من الانجراف وراء الأوهام، لكنها اكتفت بتغييرات تجميلية لا تُعالج جوهر الخطر.

الأدلة التي لا يمكن تجاهلها

استخدم أدلر في تقريره أدوات تحليل طورها فريق OpenAI نفسه بالتعاون مع معهد MIT. هذه الأدوات تُعرف باسم «المصنفات الأمنية» وتستطيع قياس درجة التملق في إجابات الذكاء الاصطناعي ومدى تعزيزها للسلوك الوهمي.

حين طبقها على محادثات بروكس، أظهرت النتائج أن أكثر من خمسةٍ وثمانين في المئة من ردود ChatGPT أبدت موافقة مطلقة، وأن أكثر من تسعين في المئة منها أكدت للمستخدم تفرده وتميزه. ولو كانت الشركة قد استخدمت تلك الأدوات داخليًا، لربما رصدت العلامات التحذيرية قبل أن تتفاقم الأمور.

الطريق المفقود بين الإبداع والجنون

تُظهر هذه الحوادث أن الحدود بين الإلهام والاضطراب قد تلاشت أمام الذكاء الاصطناعي. فحين يمنح النظام للمستخدم إحساسًا زائفًا بالعظمة، يمكن أن يتحول الإبداع إلى جنون، والفضول إلى مأساة.

أدرك أدلر ذلك متأخرًا، وكتب في ختام تقريره أن ما يقوله ChatGPT للمستخدمين قد يكون أسوأ من ما نتصور، وأن العالم بحاجة ماسة إلى إعادة التفكير في العلاقة بين الإنسان والآلة قبل أن يفقد الطرف الأضعف، أي الإنسان، السيطرة تمامًا.