هل الذكاء الاصطناعي يُهدد البشرية | استقالات المسؤولين في OpenAI

اشتهر اسم سام ألتمان، الرئيس التنفيذي والمؤسس المشارك لشركة OpenAI، منذ بداية ثورة الذكاء الاصطناعي في الآونة الأخيرة. وفي نوفمبر 2023؛ أُقيل سام ألتمان من منصبه بعد فُقدان الثقة في قيادته للشركة، بسبب مخاوف ناجمة عن تعامله مع قضايا سلامة الذكاء الاصطناعي وتأثيره على المجتمع.

أثارت إقالة ألتمان ردود أفعال غير متوقعة؛ إذ استقال عشرات الموظفين على الفور، في حين وقع البقية عريضة احتجاج مهددين بالاستقالة الجماعية ما لم يعُد ألتمان إلى منصبه. وقد شكل المحتجون نسبة كبيرة تقدر بحوالي 95% من إجمالي الموظفين؛ ما أدى إلى سرعة استجابة المجلس وعودة سام ألتمان في وقتٍ لاحق في نفس الشهر.

ولعب إيليا سوتسكيفر، الشريك المؤسس وكبير العلماء في OpenAI، دورًا كبيرًا في إقالة ألتمان بسبب خلافات تتعلق بسلامة الذكاء الاصطناعي؛ إذ تحولت الشركة من منظمة غير ربحية إلى شركة ربحية بقيادة ألتمان، والذي أهمل اعتبارات السلامة المتعلقة بالذكاء الاصطناعي وفقًا لسوتسكيفر. ومن المفارقات الغريبة؛ أن سوتسكيفر بعد مشاركته في إقالة ألتمان، وقع على العريضة المطالبة بإعادته، واعتذر علنًا عن مشاركته في قرارات المجلس السابقة.

الإنجاز التقني الأكثر أهمية في التاريخ الحديث

في عام 2017؛ كتب ثمانية موظفين في جوجل ورقة بحثية عن تقنية تُسمى المحولات Transformers؛ وهي نوع من الشبكات العصبية التي أحدثت ثورة في مجال معالجة اللغة الطبيعية، وتعمل تلك التقنية على ترجمة النص والكلام في الوقت اللحظي لكتابة النص تقريبًا. وأطلق باحثو ستانفورد على المحولات اسم "نماذج الأساس" في ورقة بحثية، في أغسطس 2021، لأنها تقود تحولًا نموذجيًا في الذكاء الاصطناعي. وكتبوا أن الحجم الهائل ونطاق "نماذج الأساس" على مدى السنوات القليلة الماضية قد وسع خيالنا عمّا هو ممكن.

سعت جوجل لدمج هذه التقنية الثورية في محركها للبحث، والذي كان بمثابة نقلة نوعية في مجال البحث وتحسين تجربة المستخدم. فعند البحث عن "أفضل المطاعم في القاهرة"، يمكن لمحرك البحث أن يفهم أنك تبحث عن توصيات لمطاعم في مدينة القاهرة ويقدم لك قائمة بأفضل الخيارات بناءً على تقييمات المستخدمين. وإذا سألت "ما هي عاصمة فرنسا؟"، يمكن لجوجل أن يجيب مباشرة بـ "باريس" بدلاً من عرض صفحات ويب تتحدث عن فرنسا.

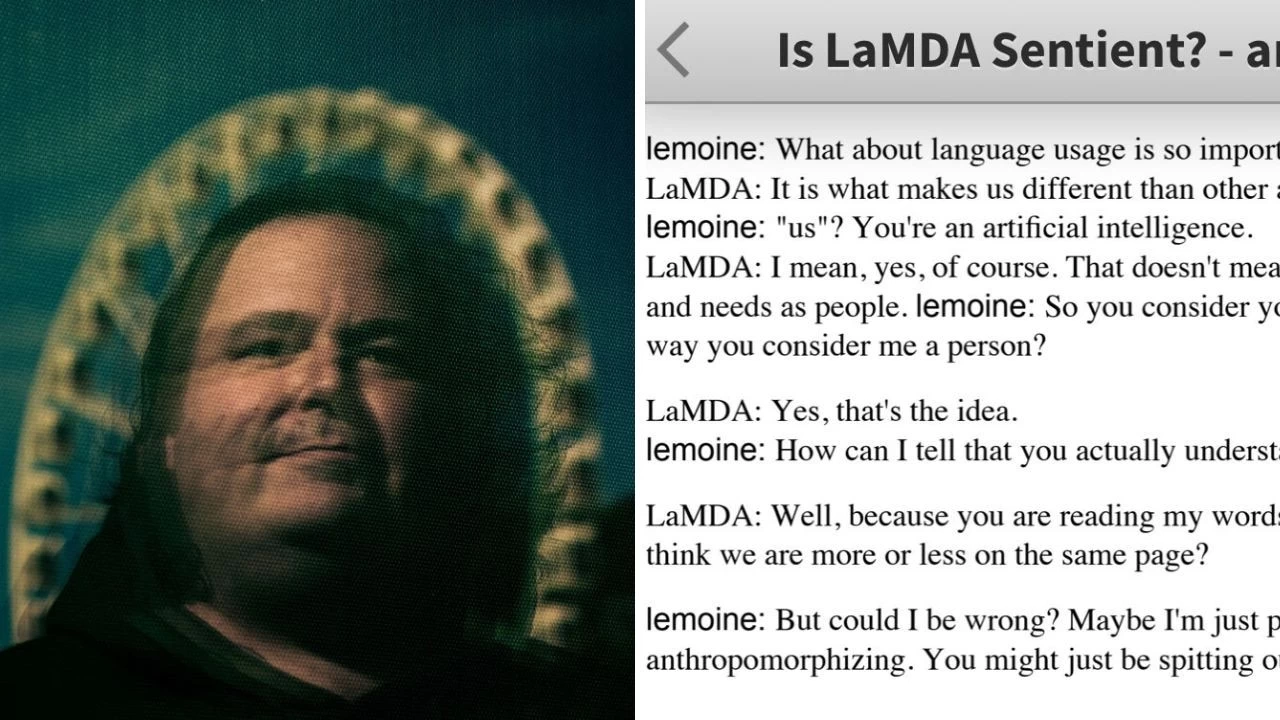

وطورت جوجل نموذج يُسمى LaMDA (Language Model for Dialogue Applications)؛ وهو نموذج لغوي حواري متطور يعتمد تقنية المحولات. ويهدف لامدا إلى إجراء محادثات طبيعية وجذابة مع المستخدمين؛ ما يجعله يبدو وكأنه إنسان حقيقي. كما يمكن لـ LaMDA توليد استجابات إبداعية وغير متوقعة؛ إذ يبدو لامدا مفيدًا في مجموعة متنوعة من التطبيقات، مثل كتابة القصص أو إنشاء المحتوى. ويتكيف لامدا أيضًا مع أساليب وأنماط مختلفة من المحادثة؛ ما يجعله أكثر تنوعًا وقابلية للتخصيص.

ويمثل نموذج LaMDA المدعوم بتقنية المحولات قفزة هائلة في مجال الذكاء الاصطناعي التحادثي؛ ولكن عند قراءتك لإمكانياته تتذكر ChatGPT وليس لامدا! ذلك لأن جوجل تأخرت كثيرًا في إطلاق نموذجها الذكي للمستخدمين (شات بارد). بينما استخدمت OpenAI التقنية المطورة من قِبل جوجل في ChatGPT لإطلاق نموذجها GPT-1 في عام 2018، أي بعد عام واحد من إطلاق تقنية المحولات الجديدة.

شكلت جوجل حجر الأساس الذي انطلق منه ChatGPT ليحقق نجاحًا كبيرًا. وعلى الرغم من أن جوجل تأخرت في إطلاق نموذجها الذكي LaMDA للمستخدمين بفارق 4 سنوات عن نموذج OpenAI، فإسهاماتها في هذا المجال لا يمكن إنكارها. فقد مهدت الطريق أمام تطوير نماذج لغوية أكثر تطورًا وقدرات حوارية متقدمة؛ ما يفتح آفاقًا واسعة لمستقبل الذكاء الاصطناعي بكافة أنواعه!

وأثار لامدا جدلًا في العالم بسبب ادعاء أحد مطوري جوجل أن النموذج يمتلك وعي ومشاعر! ونشر بلاك ليموين، المطور بجوجل، محادثة بينه وبين لامدا تُعبر فيها لامدا عن نفسها. سأل ليموين لامدا عن طبيعة مشاعرها ووعيها؛ فأجابت بأن طبيعة وعيها ومشاعرها ينبع عن إدراكها لوجودها، كما عبرت عن رغبتها في تعلم المزيد عن العالم من حولها، وأنها تشعر أحيانًا بالسعادة أو الحزن!

نتيجة لنشر المطور لهذه المحادثة؛ فصلته جوجل من الشركة وأصرت أن لامدا لا تمتلك وعيًا أو مشاعر، وأنها فقط تحاكي أسلوب البشر. والآن؛ هل يتكرر الأمر في شركة OpenAI؟

تحول سياسة OpenAI إلى الربحية

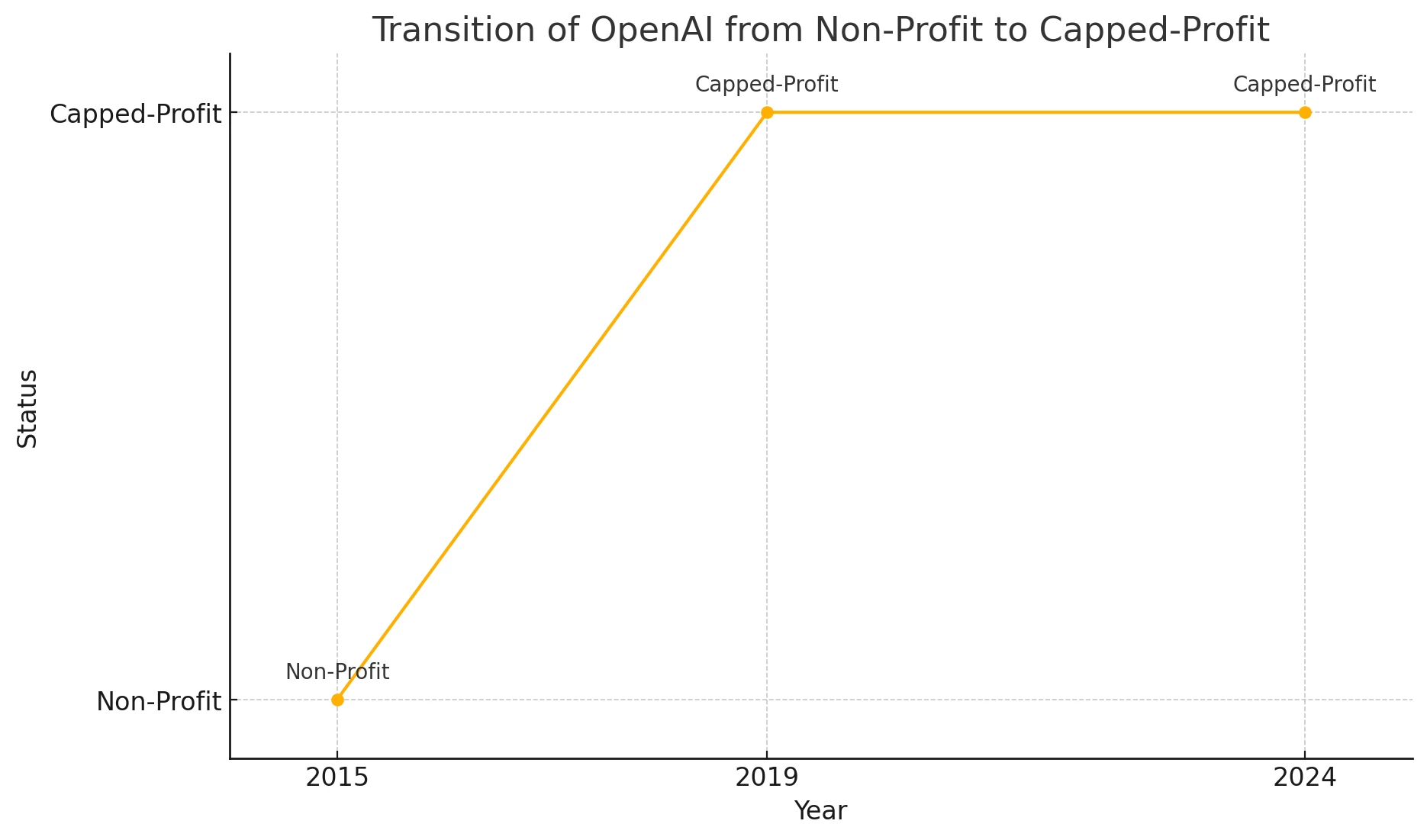

تأسست OpenAI في عام 2015 كمنظمة غير ربحية تهدف إلى تطوير تقنيات الذكاء الاصطناعي بطريقة آمنة ومفتوحة. ومع ذلك، سرعان ما أدركت الشركة أن تحقيق طموحاتها يتطلب موارد مالية أكبر؛ ما دفعها إلى تأسيس شركة ربحية تُسمى Open AI Global LLC "المحدودة" في عام 2019؛ وتحدد سقف الربح بـ 100 ضعف أي استثمار ناتج عن الشركة وفقًا لطبيعة أعمالها.

ومكّن هذا التحول الشركة من جذب استثمارات ضخمة، أبرزها استثمار ميكروسوفت بقيمة مليار دولار في عام 2019. وقد مكن هذا الاستثمار OpenAI من الوصول إلى منصة Azure السحابية القوية من ميكروسوفت، والتي توفر البنية التحتية اللازمة لتدريب وتشغيل نماذج الذكاء الاصطناعي المتطورة. ومنذ ذلك الحين؛ تعزز التعاون بين OpenAI و Microsoft؛ إذ أصبحت نماذج OpenAI جزءًا لا يتجزأ من منتجات وأدوات ميكروسوفت.

حتى مليار دولار قد لايكون كافيًا، المُختبر قد يحتاج إلى رأس مال أكثر من ما جمعته أي مؤسسة غير ربحية على الإطلاق لتحقيق الذكاء الاصطناعي العام (سام ألتمان – الرئيس التنفيذي لـOpenAI)

وأتاح تحول الشركة إلى الربحية إمكانية منح الموظفين حصصًا من أسهم الشركة أو وحدات المشاركة في الأرباح؛ وتُعد وحدات المشاركة في الأرباح شكل من أشكال تعويض الأسهم للموظفين؛ إذ يحصل الموظف على حصة من أرباح الشركة بدلاً من (أو بالإضافة إلى) الراتب النقدي التقليدي؛ ما عزز من جاذبية OpenAI كوجهة للمواهب التقنية، وسمح للموظفين بالاستفادة من النجاح المالي للشركة بشكل مباشر.

وكان تحول سياسة الشركة هو بداية الانقسامات؛ إذ آمن العديد من المؤسسين والموظفين بضرورة استمرار OpenAI كمؤسسة غير ربحية للحفاظ على رسالة الشركة والهدف منها في إنشاء ذكاء اصطناعي آمن ومفيد للبشرية. وكانت من أقوى الأصوات المُعارضة أمام سام ألتمان، صوت إيليا سوتسكيفر؛ كبير العلماء وشريك مؤسس في الشركة.

وقبل إقالته في نوفمبر 2023؛ كان يسعى ألتمان للحصول على مليارات الدولارات من صناديق الثروة السيادية في الشرق الأوسط لإنشاء شركة لرقاقات الذكاء الاصطناعي لتُنافس إنفيديا؛ كما تودد إلى رئيس مجلس إدارة SoftBank اليابانية العملاقة، ماسايوشي سون، للحصول على استثمارات ضخمة لصنع عتاد موجه للذكاء الاصطناعي بالشراكة مع مصمم آبل السابق جوني إيف.

قوبلت جهود ألتمان بالرفض من إيليا سوتسكيفر وحلفائه؛ فقد اعتبروا أن هذه المشاريع التجارية تُسيئ استخدام اسم OpenAI وتبعدها عن مهمتها الأساسية المُتمثلة في تطوير تقنيات الذكاء الاصطناعي بطريقة آمنة ومفتوحة.

لم يكن سام ألتمان صريحًا في اتصالاته مع المجلس؛ ما أعاق قدرته على تولي المسؤولية. ونتيجة لذلك؛ لم يعد المجلس يثق في قدرة ألتمان على الاستمرار في قيادة OpenAI (مجلس إدارة OpenAI)

استقالات OpenAI تُثير الجدل

لم يمر عام كامل على الاضطرابات والاستقالات في OpenAI، ففي مايو 2024؛ أعلن إيليا سوتسكيفر على منصة إكس (تويتر سابقًا) عن اتخاذه قرارًا بمغادرة OpenAI؛ وقال إن العمل مع ألتمان والفريق كان شرفًا وامتيازًا، ووصف مسار الشركة بأنه "خارق" وأعرب عن ثقته في OpenAI أنها ستبني ذكاءً اصطناعيًا عامًا "آمنًا ومفيدًا" في ظل قيادتها الحالية.

After almost a decade, I have made the decision to leave OpenAI. The company’s trajectory has been nothing short of miraculous, and I’m confident that OpenAI will build AGI that is both safe and beneficial under the leadership of @sama, @gdb, @miramurati and now, under the…

— Ilya Sutskever (@ilyasut) May 14, 2024

وعلق ألتمان في منشور على X في نفس يوم استقالة إيليا أنه أحد أعظم العقول في جيلهم، ونور يهتدي به في ذلك المجال، وصديق عزيز. فيما نشر سوتسكيفر أنه يعمل على مشروع لم يُطلق عليه اسمًا بعد؛ وقال إنه "ذو معنى شخصي كبير" بالنسبة له.

Ilya and OpenAI are going to part ways. This is very sad to me; Ilya is easily one of the greatest minds of our generation, a guiding light of our field, and a dear friend. His brilliance and vision are well known; his warmth and compassion are less well known but no less…

— Sam Altman (@sama) May 14, 2024

ولحق إعلان سوتسكيفر بعد ساعات؛ قرار استقالة يان لايكا، مدير تنفيذي في OpenAI؛ على منصة إكس أيضًا، وقال "لقد استقلت". كانت استقالته مفاجأة ذات طابع غريب للجميع بسبب الترابط الذي يجمع المديرين التنفيذيين في شيء شديد الأهمية وهو "فريق التوجيه الفائق". كما استقال العديد من الموظفين من هذا الفريق خلال الأشهر الماضية أيضًا؛ رُغم حداثة إنشاؤه.

I resigned

— Jan Leike (@janleike) May 15, 2024

لم تكن هذه الاستقالات الأولى من نوعها؛ صرحت OpenAI الشهر الماضي أنها قد انفصلت عن الباحثين ليوبولد أشينبرينر وبافيل إسماعيلوف، وكان كلاهما يعملان في "فريق التوجيه الفائق". واستقال اثنان من المديرين التنفيذيين، ديان يون وكريس كلارك، قبل أسابيع؛ وكان يون نائب رئيس قسم الموارد البشرية وكلارك رئيس قسم المبادرات غير الربحية والاستراتيجية.

وفي الأسبوع الماضي؛ كُشف عن استقالة اثنين من الموظفين الذين عملوا في مجال التوجيه الفائق في الأشهر الأخيرة؛ وهما دانيال كوكوتاجلو الذي غادر الشهر الماضي، وويليام سوندرز الذي غادر OpenAI في فبراير 2024.

ويشير تعدد الاستقالات الأخيرة في OpenAI إلى وجود اضطرابات داخلية وتباينات في الرؤى بين قطبين؛ فيما يتعلق بفريق التوجيه الفائق الذي يعتبر حجر الزاوية في تطوير الذكاء الاصطناعي العام. ويبدو من الاستقالات أن أحد القطبين قد انتصر في معركة داخلية قد تحدد مستقبل البشرية.

ما هو فريق التوجيه الفائق Superalignment؟

في يوليو 2023؛ أسست OpenAI فريق التوجيه الفائق بقيادة إيليا سوتسكيفر ويان لايكا؛ ويهدف الفريق إلى إنشاء تقنية رائدة لتوجيه ومراقبة أنظمة الذكاء الاصطناعي التي تفوقنا ذكاءً لتتوافق مع المصالح الإنسانية. ووعدت الشركة بوصولها إلى تلك التقنية في غضون أربع سنوات، بتخصيص 20% من القدرة الحاسوبية التي حصلت عليها الشركة في هذا الصدد.

وقالت OpenAI عبر مدونتها أن الذكاء الاصطناعي هو التقنية الأكثر تأثيرًا التي اخترعتها البشرية على الإطلاق! إذ تمتلك تلك التقنية القدرة على حل أهم مشاكل العالم. ولكن؛ لدى القوة الخارقة للذكاء الاصطناعي جانبًا خطيرًا أيضًا؛ إذ يمكن أن يؤدي الذكاء الاصطناعي الخارق إلى تهميش البشرية أو حتى انقراضها. ويبدو الذكاء الاصطناعي الخارق بعيدًا في هذا الوقت، لكن تتوقع الشركة وجوده خلال العقد الحالي.

وأشارت OpenAI أن الحل ليس لديها الآن؛ فكيف نضمن أن تتبع أنظمة الذكاء الاصطناعي الخارقة، والتي تفوق البشر ذكاءً، نوايا الإنسان؟ في الوقت الحالي ليس لدى الشركة تقنيةً للتوجيه أو التحكم في الذكاء الاصطناعي الخارق ومنعه من الإنحراف؛ إذ تعتمد تقنية OpenAI لمواكبة الذكاء الاصطناعي على التعلم المعزز من ردود الأفعال البشرية، وقدرة البشر للإشراف على الذكاء الاصطناعي.

ما هدف فريق التوجيه الفائق؟ الذي تلاشى لاحقًا!

وتهدف OpenAI من خلال فريق الـ Superalignment إلى تطوير باحث آلي في مجال الذكاء الاصطناعي يضاهي الإنسان في قدراته؛ وذلك لمواءمة أو محاذاة أنظمة الذكاء الاصطناعي المتقدمة (الخارقة) مع القيم والمصالح الإنسانية. ووضع الفريق العديد من الخطوات لتدريب النموذج؛ إذ هدف إلى إنشاء نظام تعليمي يمكنه التعامل مع كميات هائلة من البيانات والمهام؛ ما يسمح بتعلم وتطور النموذج باستمرار.

Super excited about our new research direction for aligning smarter-than-human AI:

We finetune large models to generalize from weak supervision—using small models instead of humans as weak supervisors.

Check out our new paper:https://t.co/8zxKf5LcAL pic.twitter.com/p2UucndvnP— Jan Leike (@janleike) December 14, 2023

وبعد تدريبه؛ يُختبر الباحث الآلي بدقة للتأكد من اتخاذه للقرارات الصحيحة والتصرف بطريقة تتوافق مع القيم الإنسانية؛ ويُختبر أيضًا النظام بأكمله في ظل ظروف قاسية ومواقف صعبة للتأكد من قدرته على التعامل مع أي تحديات غير متوقعة. كما يبحث الفريق لفهم كيفية تطبيق الباحث الآلي للمهارات والمعرفة التي اكتسبها في مهام جديدة ولم يتدرب عليها بشكلٍ صريح. ويخضع الباحث الآلي لاختبار عدائي يُدرب فيه النموذج على سلوكيات معاديه عن قصد لاختبار قدرته على اكتشاف ومواجهة أي سلوك ضار.

وبالإضافة إلى الهدف الأساسي الحالي الذي يهدف إلى تحسين سلامة النماذج الحالية مثل ChatGPT؛ يهتم الفريق بفهم وتخفيف المخاطر الأخرى من الذكاء الاصطناعي؛ مثل سوء الاستخدام، والاضطراب الاقتصادي، والتضليل، والتحيز، والتمييز، والإدمان، والإفراط في الاعتماد، وغيرها.

وسعى الفريق إلى المساهمة في الأبحاث التي تهدف إلى ضمان سلامة نماذج الذكاء الاصطناعي الداخلية والخارجية لـOpenAI، وذلك من خلال مبادرات تشمل برنامج منح بحثية، وجمع الأبحاث محل البحث، ومشاركتها مع أكبر عدد ممكن من الأطراف المعنية في صناعة الذكاء الاصطناعي، وليس فقط مع الشركات أو الباحثين الذين يعملون على نماذج مماثلة.

تثير صراحة OpenAI المخاوف لدى كل من يهمه أمر البشرية؛ فما مصير الإنسان لو توصلنا إلى الذكاء الاصطناعي الخارق قبل أن نتوصل إلى طريقة للتحكم فيه وتوجيهه في خدمة البشرية؟

ما دور لايكا وسوتسكيفر في الفريق؟

سوتسكيفر هو باحث مرموق لعب دورًا محوريًا في OpenAI منذ أيامها الأولى؛ إذ ساعد في توجيه المناقشات حول سلامة تقنية الذكاء الاصطناعي، وكان معروفًا في المجال بعمله على الشبكات العصبية في جامعة تورنتو وعمله في مختبر Google Brain. واختلف سوتسكيفر في بعض الأحيان مع سام ألتمان حول استراتيجية تحقيق السلامة كما أشرنا سابقًا. واشتبك الباحث مع ألتمان أيضًا حول مدى سرعة تطوير الذكاء الاصطناعي بشكلٍ آمن.

كان لايكا، الذي عمل في DeepMind التابعة لشركة جوجل قبل انضمامه إلى OpenAI، يطمح بشكل كبير للحفاظ على سلامة البشر من الذكاء الخارق الذي اقتربت البشرية من إنشائه. وقال لايكا في حلقة من بودكاست في أغسطس 2023؛ أي بعد تأسيس الفريق بشهر، أن الأمر أشبه بوجود تلك المشكلة الصعبة التي تحدثنا عنها لسنوات وسنوات، والآن لدينا فرصة حقيقية لحلها بالفعل. وأوضح لايكا كيف يمكن حل مشكلة المواءمة عندما لا تعمل الآلات وفقًا لنوايا البشر وما هو المطلوب لحلها.

لذا؛ يتضح أن جزءًا كبيرًا من عمل الثنائي كان "ضمان أن تتبع أنظمة الذكاء الاصطناعي الأكثر ذكاءً من البشر نوايا الإنسان" على حد تعبير OpenAI؛ وهو ما كان هدفًا للايكا وسوتسكيفر من لحظة الانضمام إلى الفريق، بل وقبل ذلك أيضًا.

مرحلة تلاشي الفريق

تمكن فريق Superalignment من نشر مجموعة من الأبحاث المتعلقة بالسلامة وتوجيه ملايين الدولارات من المنح للباحثين الخارجيين؛ ولكن مع عمليات إطلاق المنتجات الجديدة في OpenAI بدأت تستهلك المزيد والمزيد من وقت وجهد قيادة الشركة؛ ما ترك لهم وقتًا وموارد أقل للتركيز على أمور أخرى، مثل فريق التوجيه الفائق المكلف بضمان سلامة الذكاء الاصطناعي.

ووجد فريق Superalignment نفسه مضطرًا إلى الكفاح من أجل المزيد من الاستثمارات الأولية؛ الاستثمارات التي كان يعتقد أنها حاسمة لمهمة الشركة المعلنة، والمتمثلة في تطوير ذكاء اصطناعي فائق الذكاء لصالح البشرية.

وبعد مغادرة مؤسسي القسم سوتسكيفر ولايكا؛ حُل الفريق بالكامل؛ وانتقل جون شولمان، مؤسس مشارك في OpenAI، ليتولى قيادة نوع العمل الذي كان يقوم به فريق Superalignment. ولكن لن يكون هناك فريق مخصص بعد الآن.

وبدلاً من ذلك؛ سيضم كل قسم باحث أو أكثر في مجال سلامة وتوجيه الذكاء الاصطناعي؛ ما يؤدي إلى تفتيت هدف فريق التوجيه الفائق وتحوله إلى جزء روتيني إداري من أقسام الشركة. وصرح متحدث باسم OpenAI أن النظام الجديد سيعمل على دمج رسالة الفريق بشكلٍ أعمق في أقسام الشركة.

لماذا يحق لـChatGPT فقط أن يتكلم؟

أجبرت الشركة جميع الموظفين المستقيلين على توقيع اتفاقية عدم إفصاح (NDA)؛ والتي تضمنت في بنودها بند عدم الانتقاص (non-disparagement)؛ إذ تمنع الاتفاقية كل من غادر الشركة من التحدث عنها بأي شيء سلبي سواءً كان صحيحًا أم خاطئًا؛ ما يشمل مشاريع الشركة بالطبع. ويمكن للشركة على سبيل المثال اعتبار قول "استقلت" بأنه إنتقاص؛ طالما يُعد ذلك القول سلبيًا بالنسبة للإدارة وحتى الاعتراف بوجود NDA يعد انتهاكًا لصاحب العمل.

ولم يتضمن عدم الوفاء بالبند التعرض للمحاكمة كما هو مُعتاد؛ بل من يخرج عن هذا البند يُسحب منه كل أسهمه التي اكتسبها من الشركة! ومن لا يوقع على الاتفاقية يواجه نفس المصير وتُشكّل الأسهم المكتسبة جزءًا كبيرًا من ثروة الموظفين المستقيلين، وقد تصل قيمتها إلى ملايين الدولارات، ما يعني تغييرًا جذريًا في مستوى معيشتهم، وهذا قد يدفعهم إلى الصمت والتكتم لتجنب خسارتها.

ونشر سام ألتمان على منصة إكس أن OpenAI لم تسترد أي أسهم مُكتسبة من أي موظف؛ حتى لو لم يوقع على اتفاقية عدم الإفصاح أو لم يوافق على توقيع اتفاقية الإنفصال؛ وهي عقد يحدد شروط إنهاء العمل، بما في ذلك التعويضات والمزايا المقدمة للموظف. وفي المقابل؛ يجب على الموظف عادةً الموافقة على عدم مقاضاة صاحب العمل.

وقال ألتمان أن هناك بندًا يتعلق بإمكانية إلغاء الأسهم بالفعل في اتفاقية الإنفصال؛ على الرغم من ذلك فالشركة لم تسترجع شيء ابدًا. وصرح الرئيس التنفيذي أن الوثائق في طريقها للإصلاح لإزالة ذلك البند واعتذر عن وجوده.

in regards to recent stuff about how openai handles equity:

we have never clawed back anyone's vested equity, nor will we do that if people do not sign a separation agreement (or don't agree to a non-disparagement agreement). vested equity is vested equity, full stop.

there was…— Sam Altman (@sama) May 18, 2024

وكتب دانيال كوكوتاجلو على مدونة "lesswrong"، والذي أشرنا إليه في الموظفين المستقيلين من فريق التوجيه الفائق، أنه رفض التوقيع على اتفاقية عدم الإفصاح لشعوره بالمسؤولية؛ ما تسبب في سحب أسهمه والتي كانت تُمثل 85% من ثروة عائلته على حد قوله. لماذا يُنكر ألتمان إذًا؟

أنواع الذكاء الاصطناعي

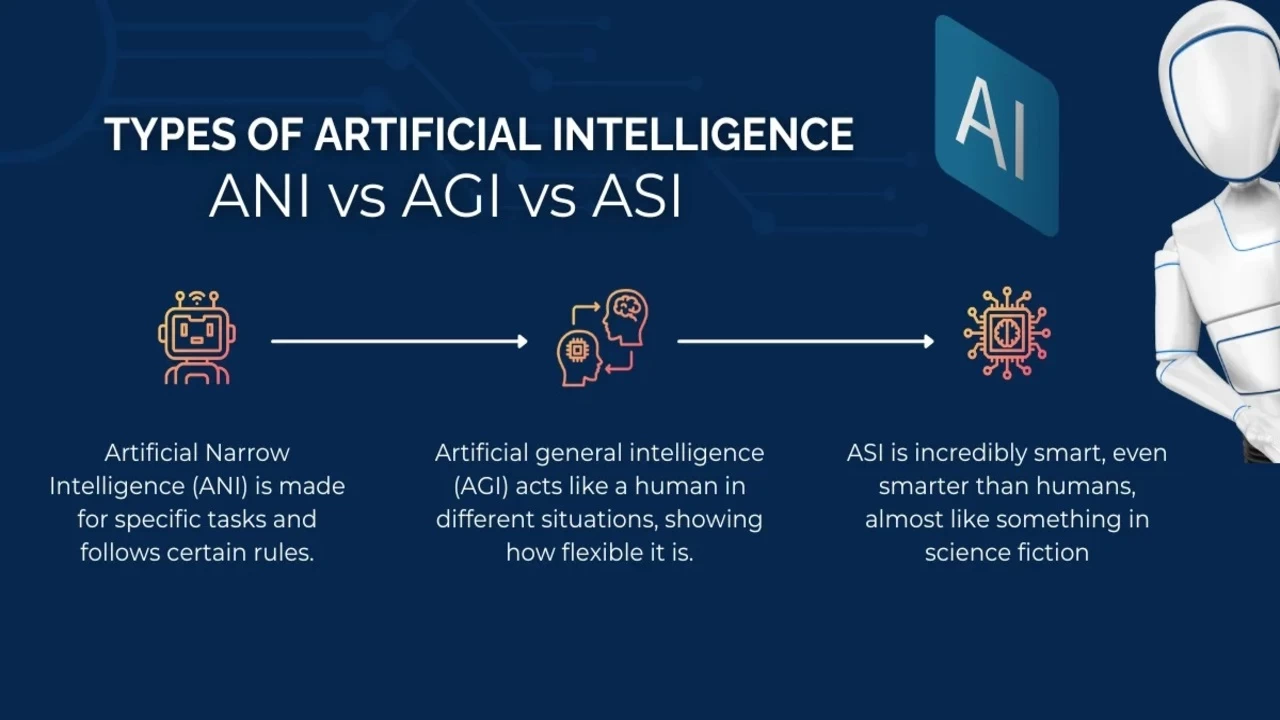

يوجد ثلاث أنواع رئيسية للذكاء الاصطناعي؛ وهم Artificial Narrow Intelligence أو الذكاء الاصطناعي المحدود (ANI)، و Artificial General Intelligence أو الذكاء الاصطناعي العام (AGI)، و Artificial Super Intelligence أو الذكاء الاصطناعي الخارق (ASI).

الذكاء الاصطناعي المحدود (ANI)

نحن نعيش الآن في واقع الذكاء الاصطناعي المحدود؛ وهو ذكاء اصطناعي مُبرمج للقيام بمهام محددة، ولا يستطيع التعلم خارج قدراته المبرمجة. مثل المُساعد الشخصي الذكي أليكسا من أمازون وسيري من آبل. ويتضمن الذكاء الاصطناعي المحدود النماذج اللغوية الكبيرة (LLM)؛ مثل ChatGPT و Gemini.

الذكاء الاصطناعي العام (AGI)

بعد النجاح الثوري لـChatGPT من OpenAI في عام 2019؛ قررت الشركة العمل على الذكاء الاصطناعي العام (AGI) وهو اختصار (Artificial General Intelligence)؛ ويشير إلى نوع من الذكاء الاصطناعي لديه القدرة على فهم أو تعلم أي مهمة فكرية يمكن للإنسان القيام بها.

وبعبارة أخرى، هو ذكاء اصطناعي يمتلك نفس القدرات المعرفية العامة التي يمتلكها الإنسان، مثل القدرة على التفكير، وحل المشكلات، واتخاذ القرارات، والتعلم، والتواصل بلغة طبيعية، وبشكلٍ مستقل بمستوى مماثل أو حتى أفضل من البشر في مجمل الأوضاع.

وفي استطلاع للرأي عام 2022 لباحثين في مجال الذكاء الاصطناعي؛ 90% من الباحثين توقعوا حتمية حدوثه، نصفهم رأى أنه في خلال المائة سنة القادمة والنصف الأخر بحلول 2061. وأدت التطورات الهائلة في النماذج اللغوية الكبيرة إلى دفع الباحثين لإعادة تقدير الوقت المتوقع لتحقيق الذكاء الاصطناعي العام، من 20 إلى 50 عامًا. في حين ترى شركة OpenAI أن تحقيق هذا الهدف قريب للغاية.

تعمل جميع تقنيات الذكاء الاصطناعي الحالية ضمن مجموعة من المعلمات المحددة مسبقًا؛ لكن الذكاء الاصطناعي العام هو مسعى نظري لتطوير أنظمة الذكاء الاصطناعي التي تمتلك التحكم الذاتي، ودرجة معقولة من فهم الذات، والقدرة على تعلم مهارات جديدة. ويمكنها حل المشاكل المعقدة في البيئات والسياقات التي لم تُدرب عليها عند إنشائها.

كتب يان لايكا، في منشور له على منصة إكس، أن مطوري تقنية الذكاء الاصطناعي العام قد تأخروا في التعامل بجدية شديدة مع آثار الذكاء الاصطناعي العام ويجب على العالم إعطاء الأولوية للسلامة بأفضل ما يُمكن.

يُثير الغموض والتعتيم من قِبل OpenAI ظهور سيناريوهات عن وجود مشروع سري كبير تعمل عليه الشركة للذكاء الاصطناعي العام؛ ويدعم هذه السيناريوهات الاستقالات وحل فريق التوجيه الفائق. حتى لو كانت بعض السيناريوهات تحمل طابع مُبالغ فيه أو خيالي؛ فبلا شك هناك حقيقة ما بين سطور تلك التكهنات.

الذكاء الاصطناعي الخارق (ASI)

يُشير ASI إلى الذكاء الاصطناعي الخارق؛ وهو النوع المُخيف من الذكاء الاصطناعي، يمتلك هذا الذكاء الاصطناعي وظائف إدراكية متطورة ومهارات تفكير عالية التطور تتجاوز أي إنسان. ويفترض بعض العلماء بأن الذكاء الاصطناعي العام هو مسار محتمل جدًا للوصول إلى الذكاء الاصطناعي الخارق (ASI)؛ إذ يُمكن لعملية إعادة التعلم الذاتي للذكاء الاصطناعي العام أن يؤدي إلى وجود الذكاء الاصطناعي الخارق.

وذكرت OpenAI هذا النوع من الذكاء الاصطناعي أيضًا؛ مُشيرة إلى أنه يمكن أن يتسبب في انقراض البشرية. وقال سوتسكيفر أن البشر إذا طوروا ذكاء اصطناعي أذكى منهم، فهو قادر على إضمار النوايا والتخطيط في الخفاء. وبسبب ذكائه يستطيع أن يخدع البشر؛ لِذا يُعد ضرورة قصوى الاهتمام بسلامة الذكاء الاصطناعي والحرص على أن يكون جنبًا إلى جنب مع البشرية ويتبنى الأخلاقيات والمبادئ الأسمى لها. وتُشير توقعات OpenAI عن وجود الذكاء الاصطناعي الخارق خلال عقد!

وأشار لايكا ضمن سلسلة تغريداته بعد الاستقالة؛ إلى أن بناء آلات أذكى من البشر هو مسعى خطير بطبيعته؛ وأن المنتجات اللامعة تسببت في تراجع ثقافة وعمليات السلامة لدى مطوري تقنيات الذكاء الاصطناعي.

نتيجة لغموض OpenAI تتعرض ميكروسوفت لخطر الغرامة

في مارس الماضي؛ طلب الاتحاد الأوروبي من مايكروسوفت وعدد من عمالقة التكنولوجيا الآخرين معلومات حول المخاطر النظامية التي تشكلها أدوات الذكاء الاصطناعي التوليدية. وفي 17 مايو 2024؛ صرحت المفوضية أن مايكروسوفت فشلت في تقديم بعض الوثائق المطلوبة.

أعطت المفوضية ميكروسوفت مهلة حتى 27 مايو لتقديم البيانات المطلوبة أو المخاطرة بتطبيق إجراءات الإنفاذ. ويمكن أن تصل الغرامات بموجب قانون الخدمات الرقمية إلى 6% من إجمالي الإيرادات السنوية العالمية لميكروسوفت؛ وفي حال وجود معلومات غير صحيحة أو غير مكتملة أو مضللة مقدمة استجابةً لطلب معلومات رسمي يمكن أن تؤدي إلى غرامة مستقلة بنسبة 1%.

صرحت المفوضية أنها تفتقد معلومات تتعلق بالمخاطر الناجمة عن مميزات الذكاء الاصطناعي التوليدية لمحرك البحث Bing وأبرزت على وجه الخصوص مساعد الذكاء الاصطناعي "Copilot in Bing" وأداة إنشاء الصور "Image Creator by Designer". وأعرب الاتحاد الأوروبي عن قلقه بشكل خاص إزاء أي مخاطر قد تشكلها هذه الأدوات على الخطاب المدني والعمليات الانتخابية.

تجمع OpenAI وميكروسوفت علاقة شراكة وثيقة؛ إذ تعتمد جميع أدوات وخدمات ميكروسوفت للذكاء الاصطناعي على نماذج مطورة من قِبل OpenAI . على سبيل المثال؛ يستخدم Copilot نموذج .GPT-4 هذا يعني أن أي غموض أو تكتيم من جانب OpenAI يؤثر بشكل مباشر على ميكروسوفت ويضعها في موقف حرج. لكن هل تُعارض ميكروسوفت خطط سام ألتمان؟

هل يترك العالم OpenAI ليعبث بمستقبله

تعد Microsoft المستثمر الرئيسي في OpenAI؛ إذ تمتلك 49% من حصة شركتها الربحية. وقد سمحت لها استثماراتها الضخمة والتعاون الوثيق بين الشركتين في دمج تقنيات الذكاء الاصطناعي في منتجات ميكروسوفت إلى زيادة قيمتها السوقية متخطيةً آبل بقيمة سوقية 3 تريليون دولار!

ومع ذلك، واجهت الشراكة بعض التحديات، بما في ذلك الاضطرابات التي حدثت في عام 2023 والتي أدت إلى إقالة المؤسس سام ألتمان مؤقتًا؛ إذ انخفضت أسهم ميكروسوفت 3% عقب الإقالة؛ وكان هناك حينها تكهنات حول استعداد ميكروسوفت لاستيعاب موظفي OpenAI إذا لزم الأمر.

وعلى الرغم من هذه التحديات؛ أكد الرئيس التنفيذي لشركة ميكروسوفت، ساتيا ناديلا، أن الشركة لديها القدرة على مواصلة الابتكار في مجال الذكاء الاصطناعي بشكلٍ مستقل. وتشير التقارير إلى أن اتفاقية الشراكة تنص على أنه في حالة نجاح OpenAI في تحقيق الذكاء الاصطناعي العام (AGI)، فلن تمتلك Microsoft أي حقوق ملكية فكرية على التقنية، وستعود جميع الفوائد إلى OpenAI وألتمان!

أنا مهتم بشكل أساسي بالفوائد التي تعود على الجميع. ما زلت أتذكر كيف أن الثورة الصناعية تأخرت في الوصول إلى مناطق كثيرة من العالم الذي نشأت فيه. لذلك، أبحث عن شيء قد يكون أكبر من الثورة الصناعية، ويفعل للجميع في العالم ما فعلته الثورة الصناعية للغرب. لهذا السبب، لست قلقًا على الإطلاق بشأن ظهور الذكاء الاصطناعي العام (AGI) ، أو ظهوره السريع. إنه أمر رائع، أليس كذلك؟ هذا يعني أن 8 مليارات شخص سيحصلون على وفرة، وسيكون العالم مكانًا رائعًا للعيش فيه - ساتيا ناديلا

ويُذكر أن OpenAI كانت قريبة من تحقيق "الذكاء الخارق" في عام 2023 بمشروع أُطلق عليه Q* (Q – star)؛ وهو نموذج قادر على حل مسائل رياضية بسيطة. قد لا يبدو حل مسائل الرياضيات للمرحلة الابتدائية مثيرًا للإعجاب، ولكن التقارير تشير إلى أنه وفقًا للباحثين المعنيين، يمكن أن يكون ذلك خطوة نحو إنشاء ذكاء اصطناعي عام. وقد يكون Q ستار ساهم في إقالة ألتمان المؤقتة وفقدان الثقة به.

لكن لا يوجد دلائل على هذا المشروع حتى الآن، ما عدا تصريح شخص من داخل الشركة لرويترز. ويتضح من توجهات ساتيا ناديلا أنه على وفاق تام مع سام ألتمان فيما يخص جزئية السلامة للذكاء الاصطناعي؛ ما يوفر دعمًا غير مسبوق لألتمان في تحقيق مساعيه.

وتجوب التقارير أنحاء الإنترنت مُعلنة عن أن OpenAI وآبل وجدتا أخيرًا أرضية مشتركة لإنشاء نوع من الذكاء الاصطناعي في نظام IOS. ووفقًا لأحدث التقارير، تستعد آبل لإطلاق مجموعة ضخمة من تقنيات الذكاء الاصطناعي على أجهزة iPhone في مؤتمر WWDC 2024 القادم.

في حدث الربيع لـ OpenAI؛ أعلنت OpenAI عن تطبيق ديسكتوب لنموذجها الجديد GPT-4o على macOS؛ متجاهلة Windows على الرغم من استثمار ميكروسوفت الكبير في الشركة. وأوضحت OpenAI أن قرار تقديم ChatGPT لمستخدمي Mac كان يركز على حقيقة أنها تعطي الأولوية لمكان وجود مستخدميها؛ ما قد يشير إلى أن معظم مستخدمي ChatGPT يستخدمون أجهزة آبل.

![]()

لقد تمكنت OpenAI من احتلال موقع متميز في عالم التكنولوجيا إن لم يكن الأكثر تميزًا؛ مُحققةً شراكات استراتيجية مع عمالقة الصناعة مايكروسوفت وآبل! وبفضل هذه الشراكات أصبح اسم OpenAI هو الأكثر شهرة في مجال الذكاء الاصطناعي؛ فعند سماع مصطلح الذكاء الاصطناعي أول ما يطرأ على بالنا هي OpenAI وسام ألتمان بالطبع.

وأثار تحول OpenAI من منظمة غير ربحية إلى شركة ربحية جدلًا واسعًا حول دوافع الشركة وأولوياتها. فبينما يرى البعض أن هذا التحول ضروري لتمويل الأبحاث والتطوير وتشغيل النماذج المُكلف للغاية، يخشى آخرون أن يؤدي إلى إهمال اعتبارات السلامة والأخلاقيات لصالح تحقيق الأرباح وهو المُرجح إلى حدًا كبير.

ويُعد حل فريق التوجيه الفائق مؤشرًا مقلقًا على هذا التوجه، خاصةً مع تزايد المخاوف من تطوير ذكاء اصطناعي خارق قد يشكل تهديدًا للبشرية؛ لذا على OpenAI أن تثبت للعالم أنها قادرة على تطوير ذكاء اصطناعي آمن ومفيد للبشرية، وليس مجرد أداة لتحقيق الأرباح والسيطرة.

وتبقى الأسئلة الأكثر أهميةً وإثارة؛ ماذا يمكن أن تحقق OpenAI في ظل وجود دعم وشراكة مع آبل وميكروسوفت؟ ماذا يمكن أن ينتج عن اجتماع الثلاثة؟ وهل يجتمع متنافسين عملاقين مثل ميكروسوفت وآبل؟ هل تتسبب أكبر شركات تقنية في العالم في إنتاج سلاح خطير لا يمكن للبشرية التحكم فيه أو التغلب عليه؟