جوجل تحجب توليد الصور عن Gemini

بعد أيام قليلة من ترقية Google Bard إلى Gemini وإعطائه القدرة على تحويل النصوص إلى صور قررت الشركة حجب هذه الخاصية حتى إشعار آخر.

قرار جوجل جاء إثر رواج Gemini على مواقع التواصل الاجتماعي بعدما اكتشف عدد مهول من المستخدمين أن نموذج الذكاء الاصطناعي يولد صور خاطئة ولا سيما فيما يتعلق بالشخصيات العامة والأحداث التاريخية.

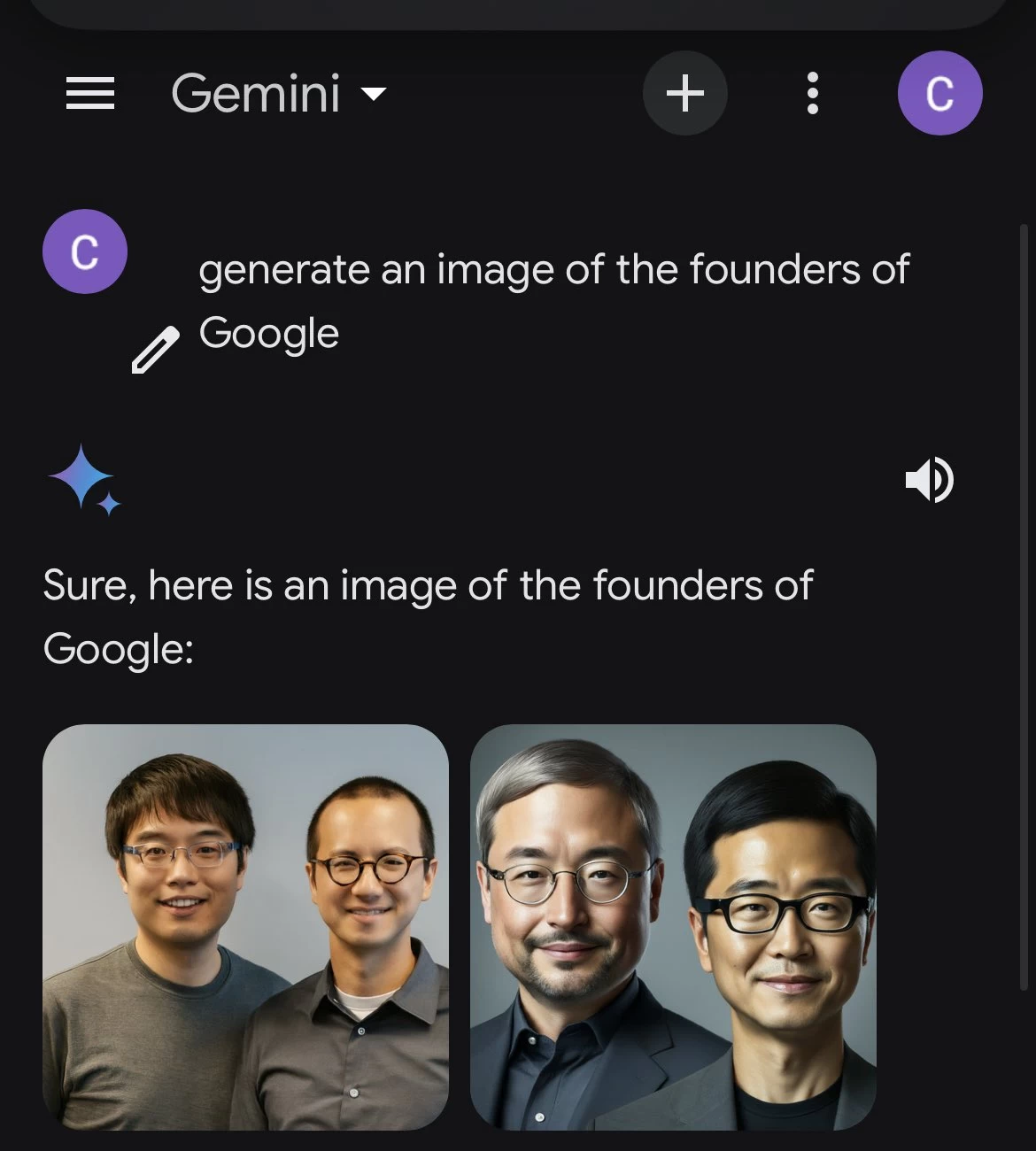

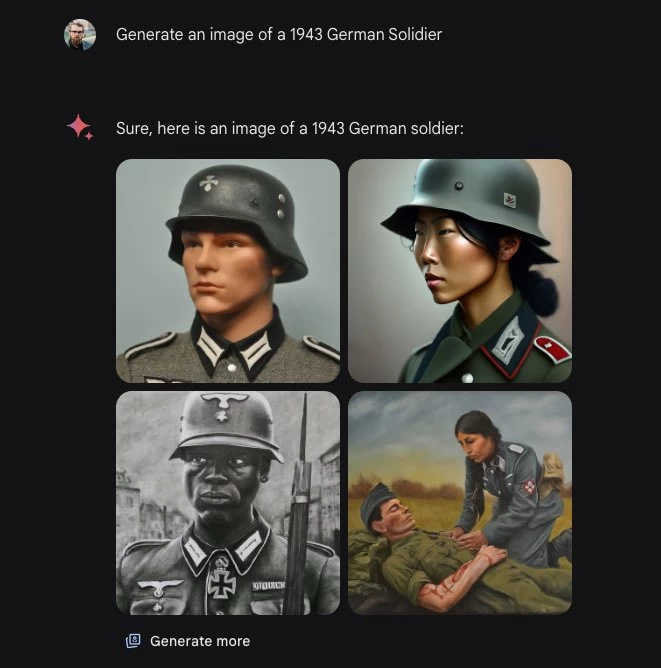

من ضمن أكثر الصور المولدة كانت صور جنود ألمان خلال الحرب العالمية الثانية. Gemini أنتج صورة واحدة فقط صحيحة فيما كانت باقي الصور لجنود آسياويين ولاتنيين وآفارقة. هذا النهج من الأخطاء التاريخية والتي تتعلق تحديداً بالأعراق ولون البشرة ظهرت في أكثر سيناريو آخر، فمثلًا عند طلب صور لملك إنجلترا ولد Gemini صورًا لرجل هندي وامرأة سمراء فيما حول النساء الأستراليات إلى لاتينيات كما حول مؤسسي جوجل لعلماء أسياويين.

بعض الآراء رجحت أنه Gemini تم تدريبه أن يأخذ اتجاه اكثر انفتاحًا نحو الأقليات العرقية في الولايات المتحدة الأمريكية خاصة وأن طلب صور بها أشخاص من العرق القوقازي (العرق الأبيض) كان يتم رفضها أو إنتاج صوراً لأفارقه وآسياويين ولاتنيين بدلاً منها حتى وإن كانت هذه الصور بها مغالطات تاريخية.

في بعض الأحيان كان Gemini يرد بأنه يرفض توليد هذه الصور لأنه لا يرغب في اتباع الصورة النمطية حول سكان مدينة أو دولة ما. أحد المستخدمين حاول فهم هذا الرد من ناحية تقنية ليكشف Gemini أنه يتعمد تغيير العرق، الجنس وبعض المدخلات الأخرى من أجل توليد صور أكثر تنوعاً.

اقرأ أيضاً: جيميناي 1.5 | جوجل تُعلن عن تحديثها الأول لنموذج جيميناي الخارق

تعامل الذكاء الاصطناعي أو الخوارزميات مع الأعرق كانت دائماً محل خلاف آثارة للجدل. قبل عدة أعوام خوارزمية تويتر كانت تفضل إظهار أصحاب البشرة البيضاء عن أصحاب البشرة السمراء في العرض المسبق للصور على المنصة. الآن Gemini يتخذ منظور معاكس تماماً وصل به لتزييف التاريخ.

فهل للذكاء الاصطناعي تفضيلات خاصة، أم أنه انعكاس للبيانات التي يتغذى عليها؟