الوجه الآخر لذكاء ChatGPT: ماذا يعني أن يكون لديه ذاكرة دائمة؟

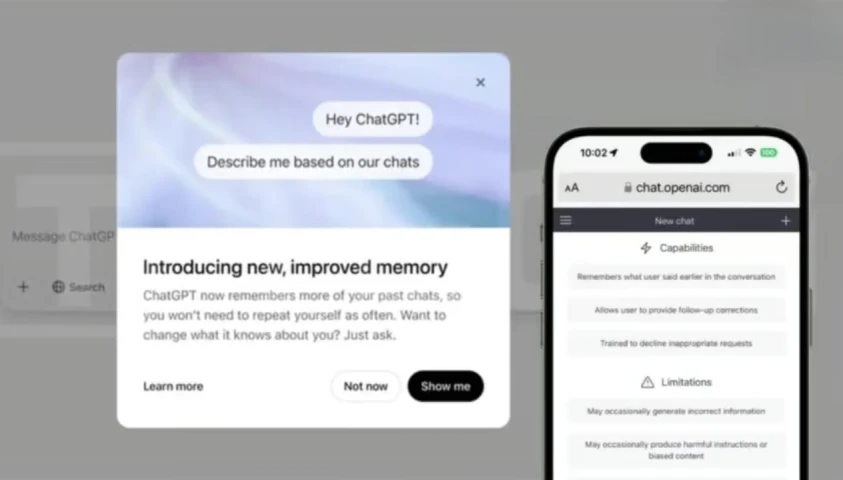

أطلقت شركة OpenAI تحديثًا رئيسيًا لـ ChatGPT يُسمى "الذاكرة طويلة المدى" أو الذاكرة الدائمة "Persistent memory"، والذي يُمكّن النموذج من تذكُّر تفاصيل مُستخدميه تلقائيًا بناءً على دردشاتهم السابقة، إلى جانب المعلومات التي يضيفونها يدويًا.

ميزة ذاكرة شات جي بي تي -المُتاحة حاليًا لمُشتركي ChatGPT Plus وPro- تهدف إلى جعل التفاعل أكثر تخصيصًا وفعالية. لكنها تثير تساؤلات حول الخصوصية، والاعتماد العاطفي، وسيطرة الذكاء الاصطناعي على بيانات المُستخدمين.

اقرأ أيضًا:

ما لا تعرفه عن خاصية التصفح الخفي: جوجل تراقبك؛ حتى في الظلام!

لماذا تتعلم برمجة الذكاء الاصطناعي؟ وما هي أفضل طريقة لتعلمه؟

جاذبية التخصيص وتكاليفه الخفية

تتمثّل الفائدة الرئيسية للذاكرة الدائمة في تقليل الحاجة إلى شرح السياق المُتكرر، حيث يتذكّر ChatGPT تفضيلاتك، وأسلوبك، وحتى أهدافك طويلة المدى. مثلًا، قد يوصي بمطعم بيتزا مع مُراعاة أهدافك الصحية، أو يقترح أفكارًا إبداعية تتماشى مع ذوقك.

يوضح روهان سارين -خبير في تقنيات الذكاء الاصطناعي- أنّ "التخصيص يرتكز على الذاكرة"، وهذا يُعزّز الثقة والارتباط العاطفي بين المُستخدم والآلة.

لكن هذا الارتباط له ثمن: الاعتماد المُتزايد على الذكاء الاصطناعي في اتخاذ القرارات اليومية، وترسيخ هوية المستخدم بناءً على بيانات قديمة.

فمثلًا، إذا ذكرت يومًا إعجابك بهاري بوتر، قد يظل ChatGPT يربط كل اقتراح إبداعي بالسحر، حتى لو تغيرت اهتماماتك. البشر ينسون بشكل انتقائي لينموا، لكن الذكاء الاصطناعي قد يحبسهم في نسخة قديمة من أنفسهم.

ذاكرة شات جي بي تي وتحديات الخصوصية

في بيئات العمل، قد تُحسّن الذاكرة الدائمة الكفاءة عبر تقليل التكرار، لكنها تطرح مخاطر كبيرة. يُحذّر جوليان ويفن -خبير في ذكاء الأعمال- من تسرُّب البيانات الحساسّة بين المشاريع، أو احتفاظ النموذج بمعلومات عابرة كان المستخدم يجرّبها فقط.

كما أن الامتثال للقوانين مثل GDPR يصبح مُعقدًا، خاصةً مع عدم وضوح آلية حذف البيانات تمامًا أو تحديد ما يتم تخزينه.

على الرغم من إتاحة خيارات مثل الدردشة المؤقتة "Temporary Chat" (التي لا تستخدم الذاكرة) أو حذف الذكريات يدويًا، يبقى القلق حول مدى شفافية النظام. يؤكّد "ويفن" الحاجة إلى "حواجز حماية واضحة وتحكم دقيق"، خاصةً في القطاعات المُنظمة مثل الصحة أو المال.

مُقارنة بالنماذج الأخرى: أين يكمُّن التوازن؟

تتبنّى منصات الذكاء الاصطناعي استراتيجيات مُختلفة للذاكرة. فبينما يتجاهلها بعضها (مثل مُحرك Perplexity الذي يعتمد على البحث الفوري)، يُركّز آخرون عليها لغرض مُحدّد، مثل Replika الذي يُخزّن البيانات العاطفية لتعزيز العلاقات. أمّا Claude فلا يحتفظ بذاكرة خارج الجلسة الحالية، وهذا يضمن خصوصية أعلى لكن بتخصيص أقل.

الذاكرة الدائمة في ChatGPT تُمثل قفزة في التكامل مع حياة المُستخدمين، لكنها أيضًا تعزّز نموذج الأعمال القائم على الاحتفاظ بالمستخدمين عبر جعلهم مُعتمدين على النظام.

السؤال الجوهري ليس عن فائدة الميزة، بل عن الحدود التي نريد وضعها لذكاء اصطناعي يعرفنا ربما أكثر ممّا نعرف أنفسنا!